Les modèles de langage ont révolutionné divers domaines avec leurs capacités avancées, laissant de nombreuses personnes avec des questions telles que la façon d’utiliser Google MusicLM et les modèles GPT d’OpenAI, y compris ChatGPT et Manuscrit, ont joué un rôle important dans cette perturbation. Ces modèles ont la capacité de générer efficacement du texte et du code en fonction d’une invite donnée. Formé sur vastes ensembles de donnéesils peuvent être appliqués à de nombreuses tâches de traitement du langage naturel (TAL), telles que analyse des sentiments, systèmes de chatbot, synthèse, traduction automatique, et classement des documents.

Bien que ces modèles aient leurs limites, ils offrent un aperçu du potentiel des modèles de langage comprendre les langues et développer des applications qui peuvent améliorer la vie humaine. Bien que des inquiétudes existent concernant leur potentiel à remplacer les humains dans divers domaines, l’idée sous-jacente est d’augmenter la productivité et de fournir de nouvelles façons d’explorer et de comprendre le langage dans son ensemble.

Donné le rôle fondamental que joue la langue dans la civilisation humaine, il devient impératif de créer des modèles de langage capables de décoder des descriptions textuelles et d’effectuer des tâches telles que la génération de texte, d’images, d’audio et même de musique. Dans cet article, nous nous concentrerons principalement sur modèles de langage musicalqui s’apparentent à des modèles comme ChatGPT et Dall-E, mais au lieu de générer du texte ou des images, ils sont conçus pour créer de la musique.

La musique est une forme d’art complexe et dynamique. Il implique l’orchestration de plusieurs instruments de musique qui s’harmonisent pour créer une expérience contextuelle. Des notes et accords individuels aux éléments de la parole comme les phonèmes et les syllabes, la musique englobe un large éventail de composants. Développement un modèle mathématique capable d’extraire des informations de un ensemble de données si diversifié est une tâche formidable. Cependant, une fois qu’un tel modèle est établi, il peut générer un son réaliste similaire à ce que les humains peuvent produire.

Avec tout cela à l’esprit, approfondissons le concept de base des modèles de langage musical et explorons comment ils permettent la génération de musique. En attendant, si vous souhaitez améliorer votre jeu musical, vous pouvez également découvrir comment utiliser Discord Soundboard et y ajouter de nouveaux sons.

Comprendre les modèles de langage musical et comment utiliser Google MusicLM

MusicLM utilise diverses techniques d’apprentissage automatique, tels que l’apprentissage en profondeur et le traitement du langage naturel, pour analyser les données et découvrir les représentations cachées qui facilitent la génération de musique. Ces modèles exploitent des ensembles de données spécifiques à la musique pour extraire des informations, identifier des modèles et apprendre un large éventail de styles et de genres musicaux.

MusicLM a le potentiel d’automatiser une gamme de tâches, y compris écrire des partitions musicales en analysant la musique existante, recommander de nouvelles progressions d’accordsou générant même de nouveaux sons. En fin de compte, il peut introduire de nouvelles formes de musique expression et la créativité, servant d’outil précieux pour améliorer les compétences des musiciens et faciliter l’éducation musicale.

Présentation de Google MusicLM

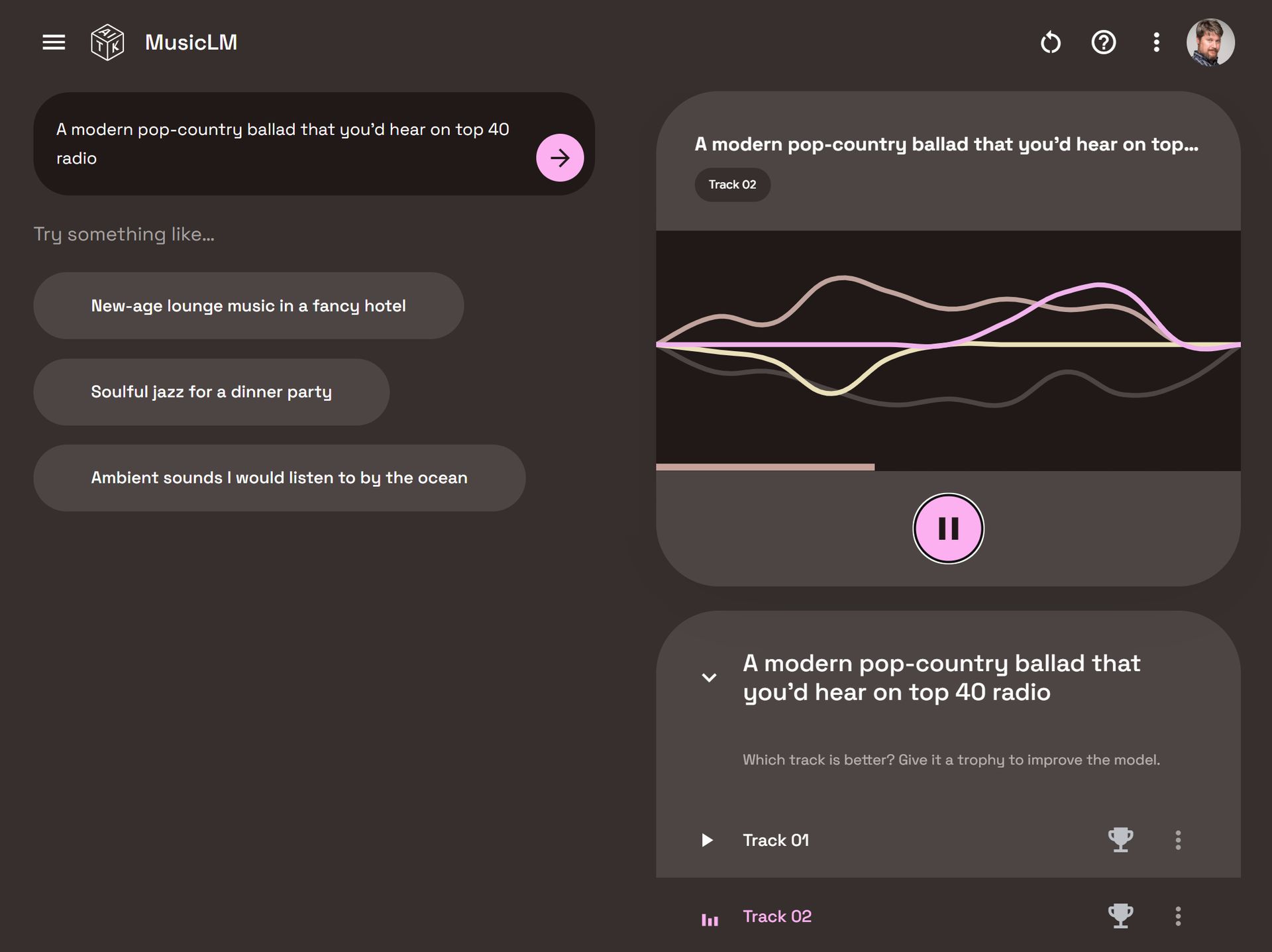

Google MusicLM est un modèle de langage dédié conçu spécifiquement pour générer de la musique basée sur des descriptions textuelles. Par exemple, en fournissant une invite comme “une mélodie de guitare apaisante dans un riff de signature rythmique 6/8”, le modèle peut produire la musique correspondante.

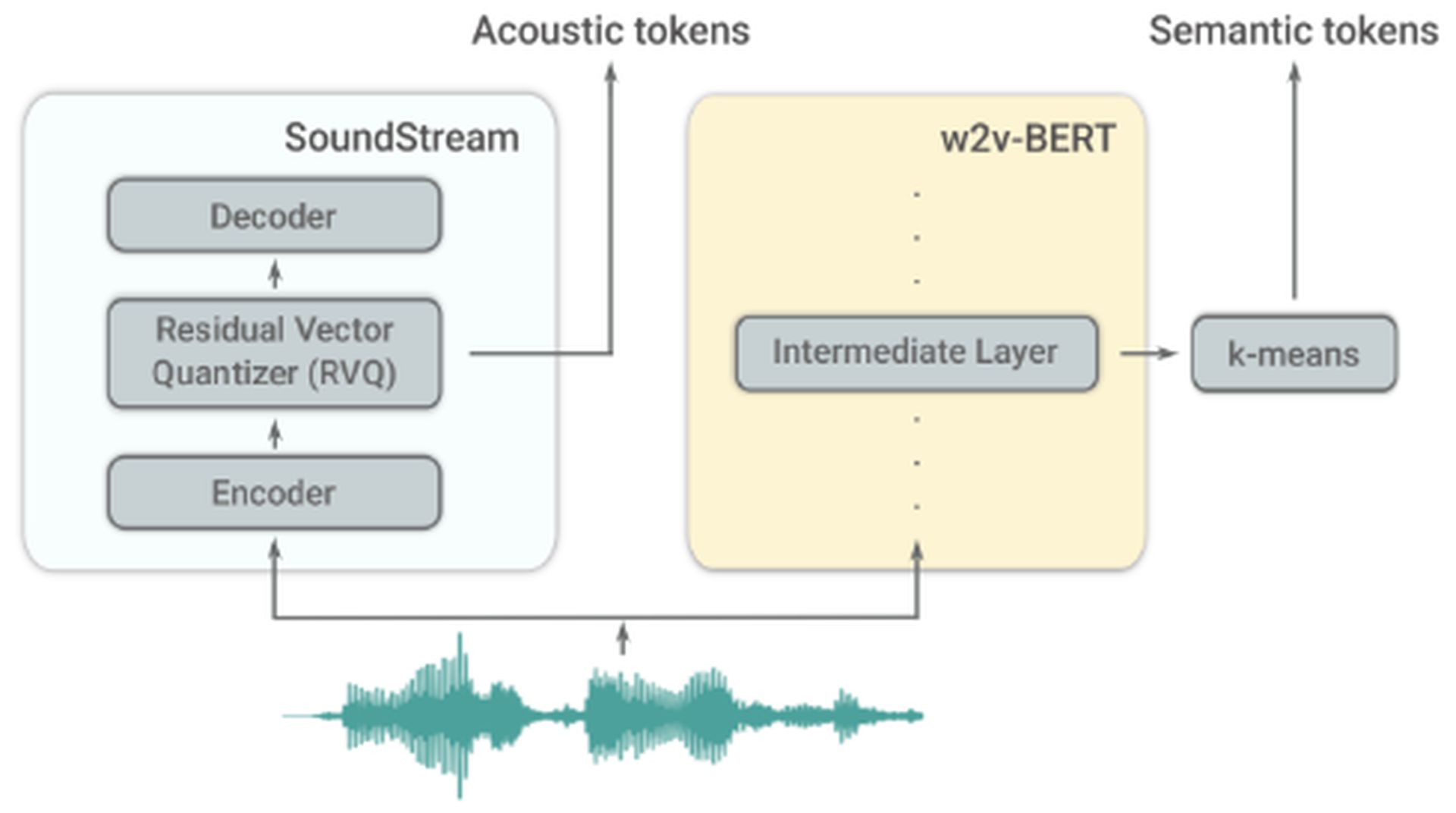

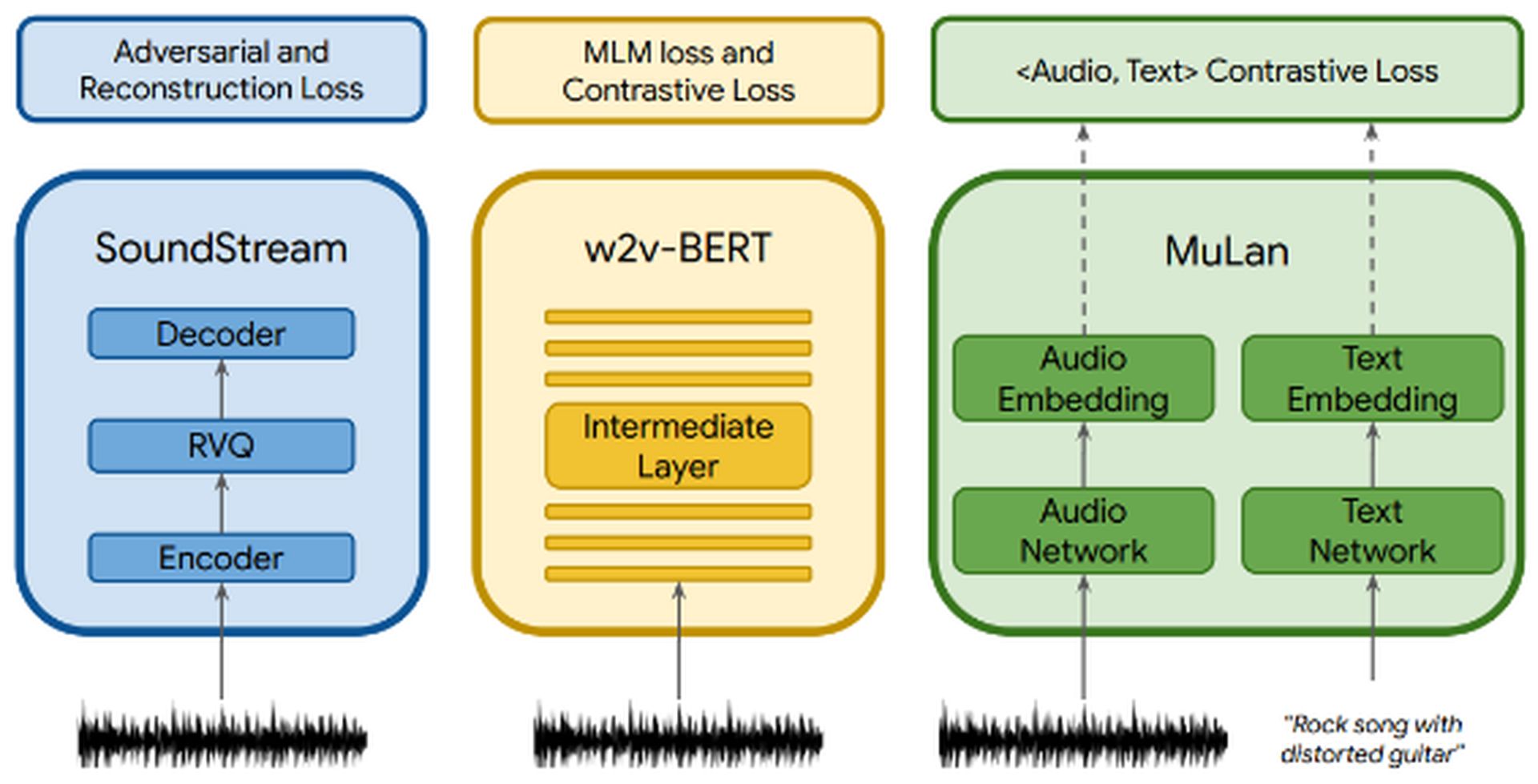

MusicLM s’appuie sur AudioLM, un autre modèle de langage développé par Google. AudioLM se concentre sur la génération haute qualité et intelligible des suites de discours et de musique pour piano. Il y parvient en convertissant l’audio d’entrée en une série de jetons discrets et générer des séquences audio avec une cohérence à long terme. AudioLM utilise deux tokenizers : le tokenizer SoundStream, qui produit des jetons acoustiques, et le générateur de jetons w2v-BERT, qui génère des jetons sémantiques. Ces tokenizers jouent un rôle crucial dans l’extraction d’informations.

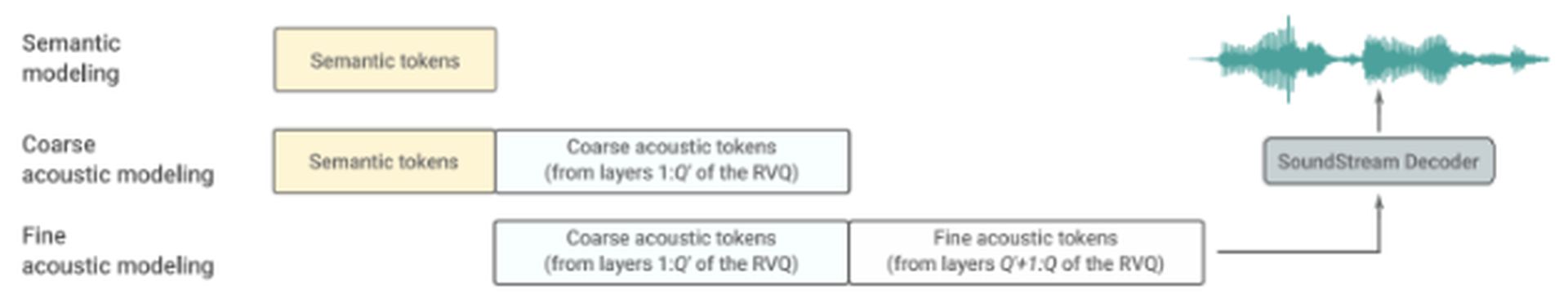

AudioLM se compose de trois étapes hiérarchiques :

- Modélisation sémantique : Cette étape se concentre sur la capture de la cohérence structurelle à long terme. Il extrait la structure de haut niveau du signal d’entrée.

- Modélisation acoustique grossière : Ici, le modèle produit des jetons acoustiques, qui sont ensuite concaténés ou conditionnés sur des jetons sémantiques.

- Modélisation acoustique fine : L’audio final reçoit plus de profondeur à cette étape, ce qui implique de traiter les jetons acoustiques grossiers avec des jetons acoustiques fins. Le décodeur SoundStream utilise ces jetons acoustiques pour recréer une forme d’onde.

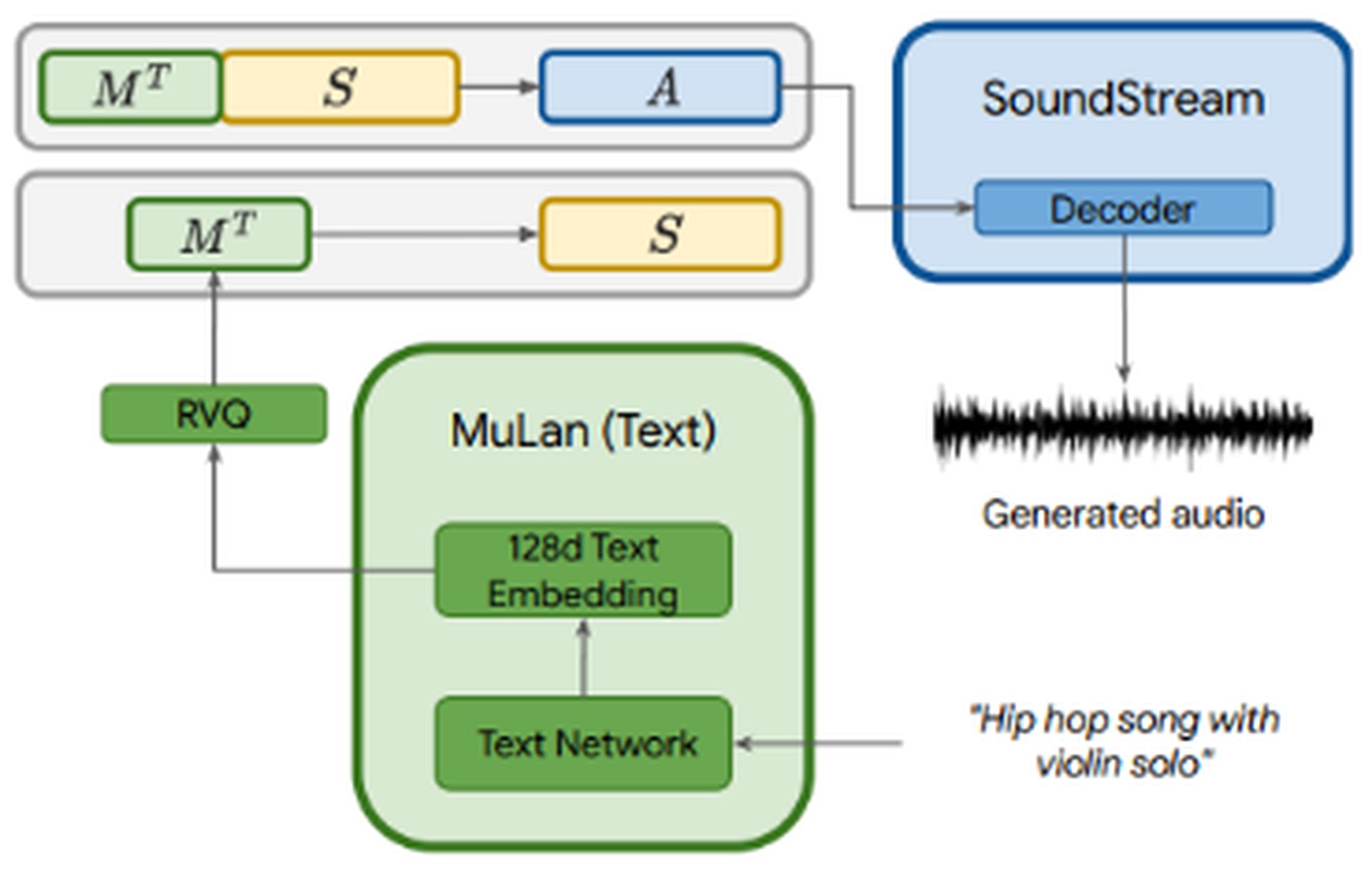

MusicLM s’appuie sur AudioLM modélisation autorégressive en plusieurs étapes comme sa composante générative, tout en incorporant conditionnement de texte. Le fichier audio passe par trois composants : SoundStream, w2v-BERT, et MuLan. SoundStream et w2v-BERT traitent et tokenisent le signal audio d’entrée, tandis que MuLan représente un modèle d’intégration conjoint pour la musique et le texte. MuLan se compose de deux tours d’encastrementun pour chaque modalité (texte et audio).

Alors que l’audio est envoyé dans les trois composants, le la description textuelle n’est introduite que dans MuLan. Les intégrations MuLan sont quantifiées pour fournir un représentation standardisée basé sur des jetons discrets pour le signal de conditionnement et l’audio. La sortie de MuLan est ensuite introduite dans le étape de modélisation sémantique, où le modèle apprend le mappage des jetons audio aux jetons sémantiques. Le processus ultérieur ressemble à celui d’AudioLM.

MusicLM, s’appuyant sur AudioLM et MuLan, offre trois avantages clés :

- Génération musicale basée sur descriptions textuelles.

- Incorporation de mélodies d’entrée pour étendre les fonctionnalités. Par exemple, en fournissant une mélodie fredonnée et en demandant à MusicLM de la convertir en riff de guitare, le modèle peut générer la sortie souhaitée.

- Génération de séquences longues pour tout instrument de musique.

Base de données

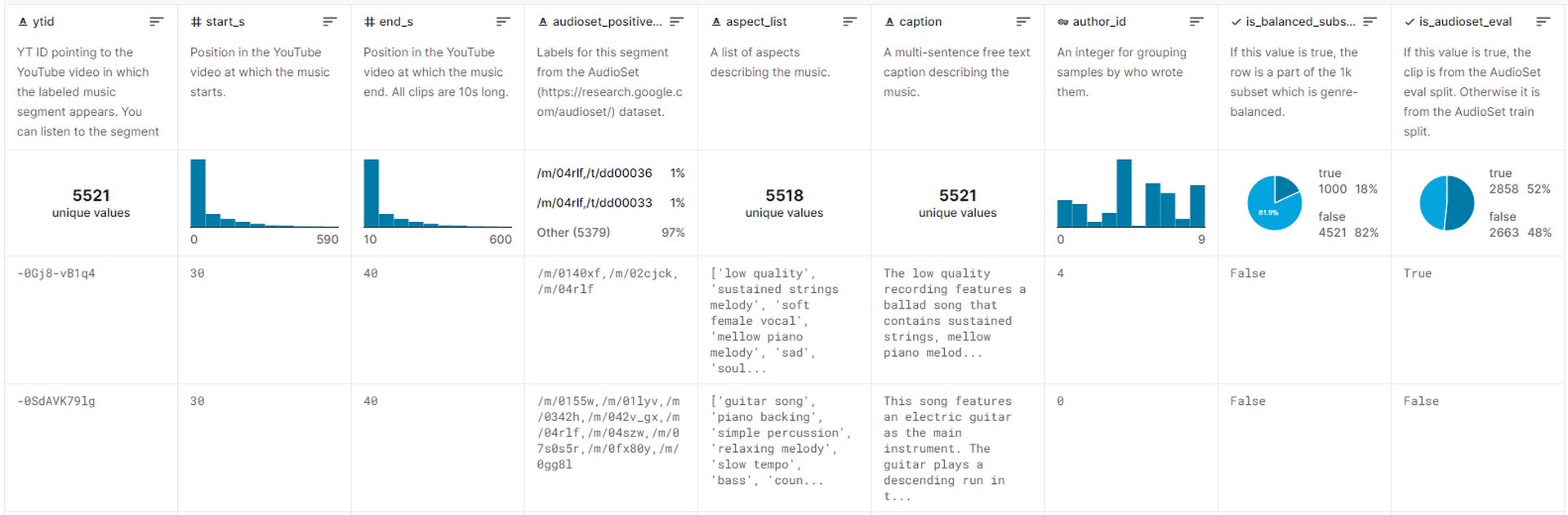

L’ensemble de données utilisé pour former MusicLM comprend environ 5.5k paires musique-texte. Cet ensemble de données comprend plus de 200 000 heures de musiqueaccompagné par descriptions textuelles enrichies fournies par des experts humains. Google a publié cet ensemble de données sur Kaggle, nommé MusicCapset il est actuellement accessible au public.

Générer de la musique avec MusicLM

Malheureusement, Google n’a actuellement pas l’intention de distribuer des modèles liés à MusicLM, invoquant la nécessité de travaux supplémentaires. Cependant, le livre blanc publié par Google fournit de nombreux exemples démontrant comment la musique peut être générée à l’aide de descriptions textuelles.

Voici plusieurs approches pour générer de la musique avec MusicLM :

- Légendes enrichies : En fournissant descriptions détaillées comme “La bande originale d’un jeu d’arcade. Il est rapide et optimiste, avec un riff de guitare électrique accrocheur. La musique est répétitive et facile à retenir, mais avec des sons inattendus comme des crashs de cymbales ou des roulements de tambour », MusicLM peut créer de la musique qui s’aligne sur des contextes et des exigences spécifiques.

- Longue génération : Cette approche implique la génération d’un son continu et haute fidélité pendant de longues périodes, telles que 5 minutes. En utilisant des invites telles que “Heavy metal” ou “reggae apaisant”, les utilisateurs peuvent obtenir de la musique dans le genre et le style souhaités.

- Mode histoire: Une caractéristique notable de MusicLM est la possibilité de générer une séquence musicale basée sur une série d’invites de texte. Par exemple, en spécifiant différents intervalles de temps et les activités correspondantes telles que “temps pour méditer (0:00-0:15)“, “heure du réveil (0:15-0:30)», etc., les utilisateurs peuvent orchestrer un voyage musical.

- Conditionnement du texte et de la mélodie : Cette approche permet aux utilisateurs de produire de la musique qui adhère à une mélodie fournie, telle que une séquence de bourdonnement ou de sifflement tout en respectant l’invite de texte donnée. Essentiellement, il convertit une séquence audio en la sortie souhaitée.

- Conditionnement de la légende de la peinture : MusicLM peut générer de la musique basée sur des descriptions de peinture. Par exemple, en fournissant une description de l’œuvre célèbre de Salvador Dali “La persistance de la Mémoire», le modèle peut créer une musique inspirée des concepts et de l’imagerie du tableau.

- Lieux: Les descriptions de lieux ou d’environnements spécifiques peuvent servir d’invites pour générer de la musique. Par exemple, en utilisant une description comme “un moment ensoleillé et paisible au bord de la plage“, MusicLM peut générer une musique qui résume l’essence de ce cadre.

Des exemples supplémentaires incluent la génération audio 10s à partir de texte, en tenant compte des niveaux d’expérience des musiciens, des époques et même des solos d’accordéon. MusicLM offre un ensemble polyvalent de fonctionnalités pour générer de la musique dans divers domaines et scénarios.

Les capacités impressionnantes de MusicLM à générer musique haute fidélité mettre en valeur le potentiel remarquable de la créativité humaine plutôt que de s’appuyer uniquement sur des algorithmes d’IA. Cependant, cette avancée soulève également préoccupations éthiques et peut faire face à la résistance de la communauté musicalesimilaires aux modèles de génération d’images tels que Dalle et ChatGPT.

Les chercheurs de Google reconnaissent les enjeux éthiques associé à un système comme MusicLM, y compris le potentiel de incorporation de contenu protégé par des droits d’auteur à partir de données de formation dans les chansons générées. Au cours d’expériences, ils ont découvert que 1% de la musique générée par le système reproduisait directement des chansons à partir de ses données d’entraînement. Ce pourcentage a été jugé trop haut pour publier MusicLM sous sa forme actuelle.

Bien qu’il soit peu probable que MusicLM devienne une application accessible au public dans un proche avenir, nous pouvons anticiper l’émergence de modèles musicaux open source qui pourraient être rétro-conçus par des développeurs indépendants. L’avenir tient des possibilités passionnantes pour tirer parti des modèles de langage pour améliorer la créativité et l’expression musicales tout en garantissant l’utilisation responsable et éthique de ces technologies.