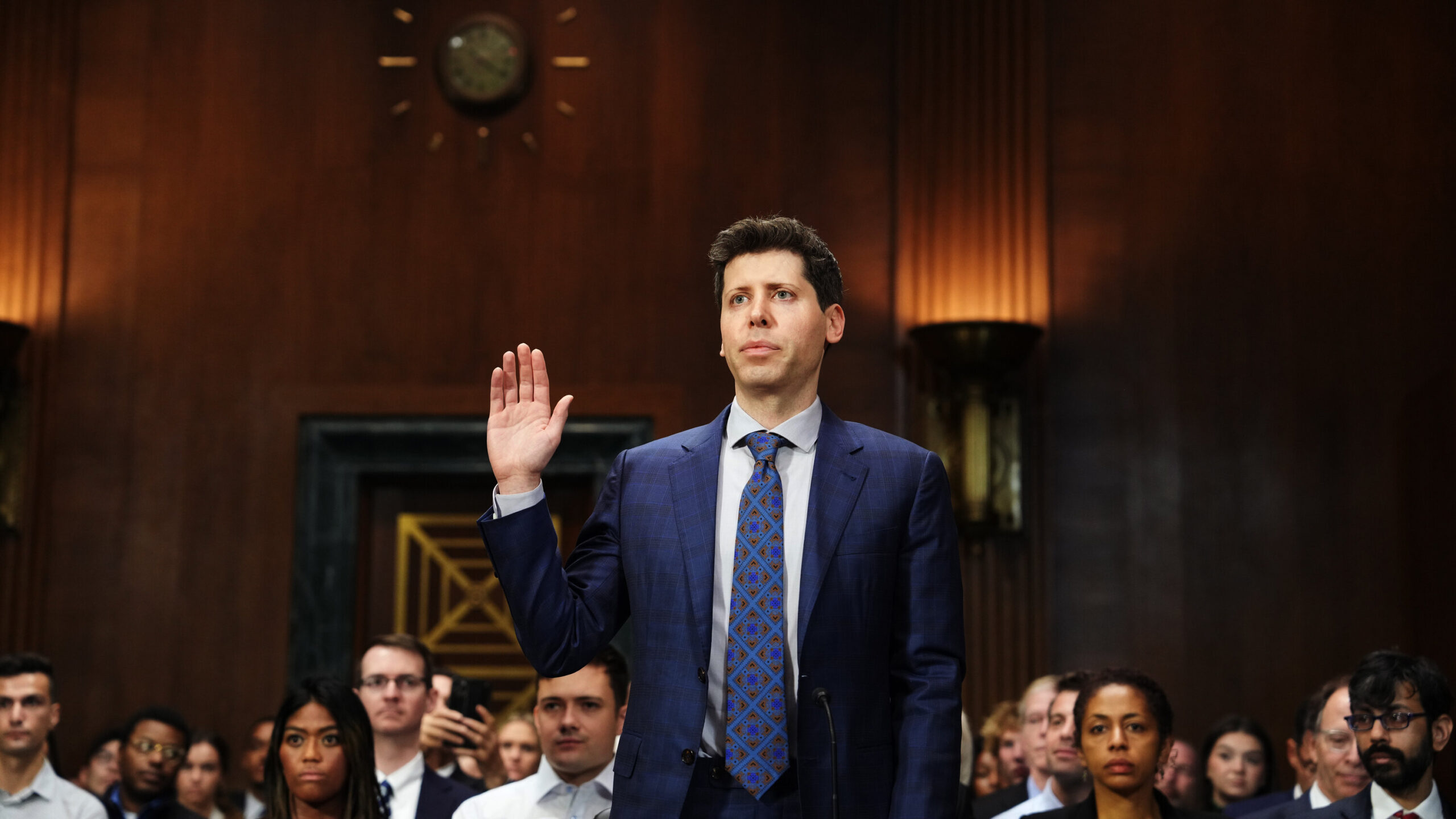

PDG d’OpenAI Sam Altmann poursuit son rayonnement international, en s’appuyant sur l’élan généré par ses récentes apparitions devant le Congrès américain. Cependant, l’approche d’Altman à l’étranger diffère du climat favorable à l’IA aux États-Unis, car il fait allusion à la possibilité de déplacer ses entreprises technologiques si le respect de ses règles n’est pas respecté.

Le voyage de globe-trotter d’Altman l’a emmené de Lagos, Nigéria vers diverses destinations européennes, aboutissant à Londres, Royaume-Uni. Malgré quelques protestations, il s’engage activement avec des personnalités de l’industrie technologique, des entreprises et des décideurs politiques, soulignant les capacités du modèle de langage ChatGPT d’OpenAI. Altman cherche à rallier le soutien aux réglementations pro-IA tout en exprimant son mécontentement face à la définition de l’Union européenne des systèmes “à haut risque”, comme discuté lors d’un panel à l’University College de Londres.

Le Proposition de loi sur l’IA proposée par l’Union européenne introduit une classification à trois niveaux pour les systèmes d’IA basée sur les niveaux de risque. Les cas d’IA qui présentent un «risque inacceptable» en violant les droits fondamentaux comprennent les systèmes de notation sociale et l’IA d’ingénierie sociale manipulatrice. D’autre part, les «systèmes d’IA à haut risque» doivent respecter des normes complètes de transparence et de surveillance, adaptées à leur utilisation prévue.

Sam Altman a exprimé des inquiétudes concernant le projet de loi actuel, déclarant que ChatGPT et le prochain GPT-4 pourraient potentiellement tomber dans la catégorie à haut risque. Le respect d’exigences spécifiques serait nécessaire dans de tels cas. Altman a souligné l’intention d’OpenAI de s’efforcer de se conformer, mais a reconnu qu’il existe des limitations techniques qui peuvent avoir un impact sur leur capacité à le faire. Comme rapporté par Time, il a déclaré : « Si nous pouvons nous conformer, nous le ferons, et si nous ne le pouvons pas, nous cesserons nos activités… Nous essaierons. Mais il y a des limites techniques à ce qui est possible.

La loi sur l’IA de l’UE est mise à jour à mesure que l’IA s’améliore

Initialement destinée à répondre aux préoccupations liées au système de crédit social et à la reconnaissance faciale en Chine, la loi sur l’IA a rencontré de nouveaux défis avec l’émergence d’OpenAI et d’autres startups. L’UE a ensuite introduit des dispositions en décembre, ciblant les “modèles fondamentaux” comme les grands modèles linguistiques (LLM) alimentant les chatbots d’IA tels que ChatGPT. Récemment, une commission du Parlement européen a approuvé ces réglementations mises à jour, imposant des contrôles de sécurité et une gestion des risques.

Contrairement aux États-Unis, l’UE a montré une plus grande propension à surveiller OpenAI. Le Comité européen de la protection des données a surveillé activement la conformité de ChatGPT avec les lois sur la confidentialité. Cependant, il est important de noter que la loi sur l’IA est toujours sujette à des révisions potentielles, ce qui explique probablement la tournée mondiale d’Altman, cherchant à naviguer dans le paysage en évolution de la réglementation sur l’IA.

Altman a réitéré des points familiers de son récent témoignage au Congrès, exprimant à la fois des préoccupations concernant les risques de l’IA et la reconnaissance de ses avantages potentiels. Il a plaidé pour une réglementation, y compris des exigences de sécurité et une agence gouvernementale pour les tests de conformité. Altman a appelé à une approche réglementaire qui établit un équilibre entre les traditions européennes et américaines.

Cependant, Altman a mis en garde contre les réglementations qui pourraient limiter l’accès des utilisateurs, nuire aux petites entreprises ou entraver le mouvement de l’IA open source. La position évolutive d’OpenAI sur l’ouverture, citant la concurrence, contraste avec ses pratiques antérieures. Il convient de noter que toute nouvelle réglementation bénéficierait intrinsèquement à OpenAI en fournissant un cadre de responsabilité. Les contrôles de conformité pourraient également augmenter le coût de développement de nouveaux modèles d’IA, donnant à l’entreprise un avantage dans le paysage concurrentiel de l’IA.

Plusieurs pays ont imposé des interdictions sur ChatGPT, l’Italie étant l’un d’entre eux. Cependant, après qu’OpenAI ait amélioré les contrôles de confidentialité des utilisateurs, l’interdiction a été levée par le gouvernement d’extrême droite italien. OpenAI devra peut-être continuer à répondre aux préoccupations et à faire des concessions pour maintenir une relation favorable avec les gouvernements du monde entier, en particulier compte tenu de sa large base d’utilisateurs de plus de 100 millions d’utilisateurs actifs de ChatGPT.

Pourquoi les gouvernements agissent-ils avec prudence vis-à-vis des chatbots IA ?

Il existe un certain nombre de raisons pour lesquelles les gouvernements peuvent imposer des interdictions sur ChatGPT ou des modèles d’IA similaires pour plusieurs raisons :

- Désinformation et fausses nouvelles: Les modèles d’IA comme ChatGPT peuvent générer des informations trompeuses ou fausses, contribuant à la propagation de fausses informations. Les gouvernements peuvent imposer des interdictions pour empêcher la diffusion de contenus inexacts ou préjudiciables.

- Contenu inapproprié ou offensant: Les modèles d’IA ont le potentiel de générer du contenu inapproprié, offensant ou contraire aux normes et valeurs culturelles. Les gouvernements peuvent interdire ChatGPT pour protéger les citoyens contre les contenus répréhensibles.

- Préoccupations éthiques: Les modèles d’IA soulèvent des questions éthiques liées à la vie privée, au consentement et aux préjugés. Les gouvernements peuvent imposer des interdictions pour répondre aux préoccupations concernant la confidentialité des données, l’utilisation abusive potentielle des informations personnelles ou la perpétuation de préjugés dans le contenu généré par l’IA.

- Conformité réglementaire: Les modèles d’IA doivent respecter les lois et réglementations en vigueur. Les gouvernements peuvent imposer des interdictions s’ils constatent que ChatGPT ne respecte pas les exigences réglementaires, telles que la protection des données ou les normes de contenu.

- Sécurité nationale et stabilité sociale: Les gouvernements peuvent percevoir les modèles d’IA comme une menace potentielle pour la sécurité nationale ou la stabilité sociale. Ils peuvent imposer des interdictions pour empêcher l’utilisation abusive de la technologie de l’IA à des fins malveillantes ou pour maintenir le contrôle du flux d’informations.

Il convient de noter que les raisons spécifiques des interdictions imposées par le gouvernement sur ChatGPT peuvent varier d’une juridiction à l’autre, et les décisions sont influencées par une combinaison de facteurs juridiques, éthiques, sociétaux et politiques. Pour certains risques actuels et conséquences indésirables des chatbots IA, consultez ces derniers articles :

- Risques ChatGPT exposés : Comprendre les menaces potentielles

- Le côté obscur de ChatGPT : le coût humain du succès de l’IA

Source: Sam Altman d’OpenAI menace de quitter l’UE au milieu des discussions sur la réglementation de l’IA