Le Meta Llama 3.1 405B a été officiellement annoncé, se faisant un nom avant même que ses capacités d’IA ne soient lancées. Développé par Meta, ce modèle de pointe offre une flexibilité, un contrôle et des performances sans précédent pour rivaliser avec les meilleurs modèles d’IA à code source fermé.

Hier, certains utilisateurs ont eu un avant-goût de son potentiel et aujourd’hui, nous avons des tests de référence officiels mettant en évidence ses capacités impressionnantes. Vous pouvez également en savoir plus sur les révélations d’hier ici.

Qu’est-ce que Meta Llama 3.1 405B ?

Aujourd’hui, nous allons découvrir tout ce qu’il y a à savoir sur Meta Llama 3.1 405B. Llama 3.1 405B est une IA open source qui excelle dans une variété de tâches telles que la culture générale, la navigabilité, les mathématiques, l’utilisation d’outils et la traduction multilingue, tandis que les versions de niveau intermédiaire 70B et de niveau minimal 8B excellent également dans leurs classes respectives. Avec une longueur de contexte de 128 K et la prise en charge de huit langues, ce modèle est conçu pour gérer des applications complexes et diverses.

Formé sur plus de 15 000 milliards de jetons utilisant plus de 16 000 GPU H100, Llama 3.1 405B se distingue comme l’un des modèles d’IA les plus puissants et les plus performants disponibles. Beaucoup d’énergie a été investie dans cette IA. Nous pouvons maintenant commencer à nous intéresser aux aspects techniques.

Principales caractéristiques du Meta Llama 3.1 405B

Méta Llama 3.1 405B offre plusieurs fonctionnalités avancées :

- Longueur de contexte étendue:Prend en charge une longueur de contexte allant jusqu’à 128 Ko, idéal pour le résumé de texte long et les conversations complexes.

- Capacités multilingues:Gère plusieurs langues, ce qui le rend polyvalent pour les applications mondiales.

- Utilisation avancée des outils:Capable de s’intégrer à divers outils pour des fonctionnalités améliorées.

- Génération de données synthétiques:Facilite la création de données synthétiques pour améliorer et former des modèles plus petits.

- Distillation modèle:Permet la distillation de grands modèles en versions plus petites et plus efficaces.

Meta s’est associé à plus de 25 entreprises pour réaliser Méta Llama 3.1 405B plus facile à utiliser. Ce support écosystémique permet aux développeurs et aux chercheurs de travailler plus facilement avec ce modèle puissant, même sans accès à des ressources informatiques massives.

Comment utiliser Meta Llama 3.1 405B

Pour commencer à utiliser Meta Llama 3.1 405B, suivez ces étapes :

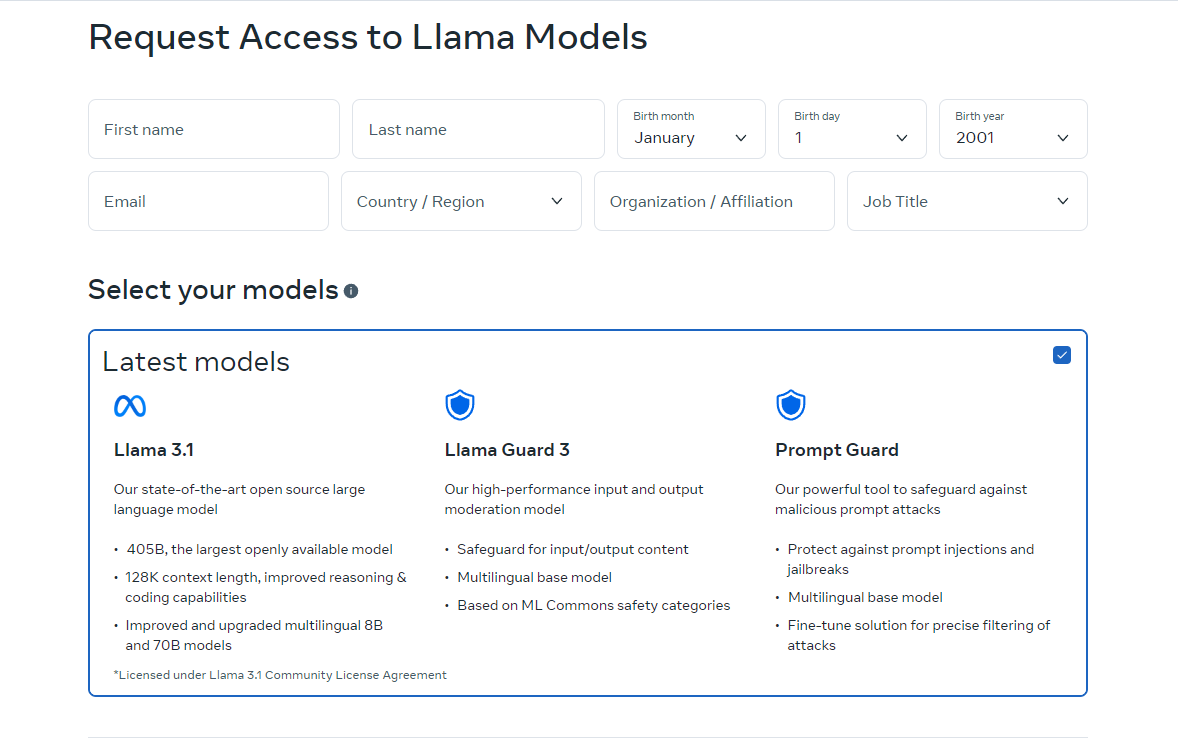

- Accéder au modèle: Visite lama.meta.com ou Visage qui fait un câlin à télécharger le modèle. Ces plateformes fournissent les fichiers et la documentation nécessaires pour démarrer.

- Configurez votre environnement: Assurez-vous de disposer d’un environnement adapté à l’exécution du modèle. Cela implique de disposer du matériel requis, comme les GPU, et des dépendances logicielles telles que Python et PyTorch.

- Charger le modèle:Utilisez les extraits de code et les instructions fournis pour charger le modèle dans votre application. Meta fournit des instructions détaillées pour vous aider à intégrer Llama 3.1 405B dans vos projets.

- Exécuter l’inférence:Commencez à utiliser le modèle pour des inférences en temps réel ou par lots. Vous pouvez poser des questions au modèle, générer du texte ou effectuer des traductions à l’aide de ses puissantes fonctionnalités.

- Ajuster pour des tâches spécifiques:Si nécessaire, vous pouvez affiner le modèle pour des applications spécifiques à l’aide de techniques de réglage supervisées. Meta propose des ressources et des exemples pour vous guider dans ce processus.

La version en ligne de Llama n’est actuellement disponible que dans certains pays. Cependant, vous pouvez également l’utiliser localement en téléchargeant les codes open source. Les instructions de téléchargement sont disponibles sur les sites vers lesquels nous vous dirigeons. Vous pouvez également utiliser Meta Llama 3.1 405B via Grog.

Comment utiliser Meta Llama 3.1 405B sur Groq

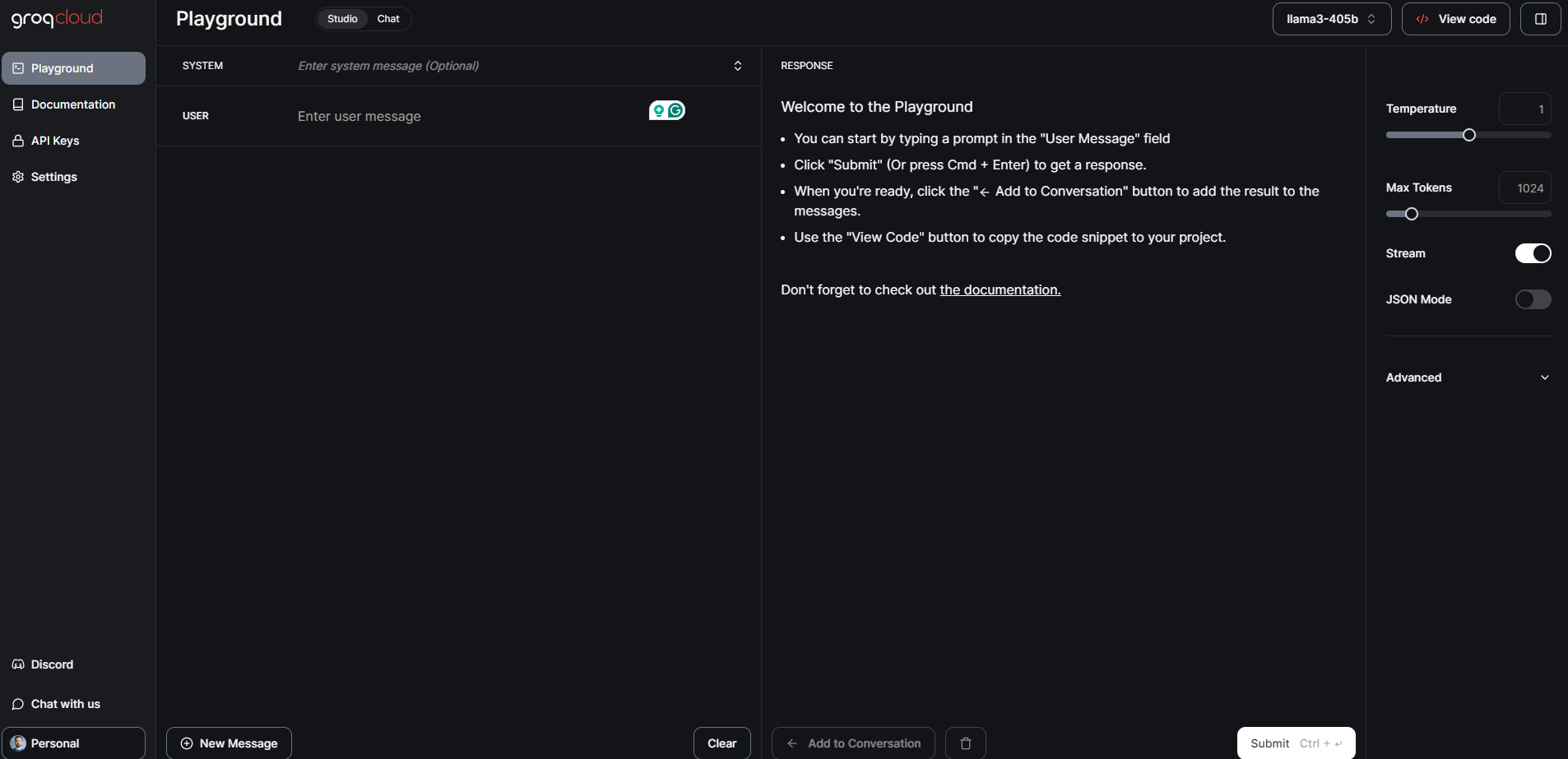

Meta Llama 3.1 405B, le modèle de fondation ouverte le plus grand et le plus performant à ce jour, est désormais disponible sur Groq. Ce guide vous guidera dans la mise en route de Meta Llama 3.1 405B sur Groq.

Étape 1 : Console de développement GroqCloud

- S’inscrire Se connecter: Visiter le Console de développement GroqCloud et inscrivez-vous ou connectez-vous à votre compte.

- Trouver les modèles Meta Llama 3.1: Accédez à la section modèles et recherchez Meta Llama 3.1 405B. Vous trouverez également les modèles Instruct 70B et 8B disponibles.

- Obtenir une clé API: Obtenez une clé API Groq gratuite depuis la console. Cette clé vous permettra d’interagir avec le modèle.

GroqChat

Pour l’accès au grand public, vous pouvez utiliser GroqChat :

- Visitez GroqChat: Aller à GroqChat pour interagir directement avec Meta Llama 3.1 405B.

- Découvrir les fonctionnalités: Testez les capacités du modèle en temps réel, telles que la génération de texte, les traductions ou la réponse aux requêtes.

Étape 2 : Configuration de votre environnement

Configuration matérielle et logicielle requise

- Matériel: Assurez-vous de disposer du matériel adapté, de préférence des GPU, pour gérer les exigences du modèle.

- Logiciel:Installez les dépendances logicielles nécessaires telles que Python et PyTorch. Vous trouverez des instructions de configuration détaillées sur la console de développement GroqCloud.

Configuration de l’environnement

- Intégration API:Remplacez votre clé API standard existante par la clé API Groq.

- Définir l’URL de base:Configurez votre application pour utiliser l’URL de base de Groq pour les requêtes API.

Étape 3 : chargement et exécution du modèle

Chargement du modèle

- Extraits de code:Utilisez les extraits de code fournis sur la console de développement GroqCloud pour charger Meta Llama 3.1 405B dans votre application.

- Initialisation: Initialisez le modèle avec la clé API et configurez tous les paramètres nécessaires à votre cas d’utilisation spécifique.

Inférence en cours d’exécution

- Inférence en temps réel:Commencez à exécuter des inférences en temps réel en envoyant des requêtes au modèle et en recevant des réponses.

- Le traitement par lots:Pour les tâches plus importantes, vous pouvez utiliser le traitement par lots pour gérer plusieurs requêtes simultanément.

Étape 4 : Ajustement pour des tâches spécifiques

- Données d’entraînement:Préparez votre ensemble de données pour l’application spécifique pour laquelle vous souhaitez affiner le modèle.

- Processus de mise au point:Suivez les instructions détaillées fournies par Meta et Groq pour affiner le modèle à l’aide de techniques supervisées.

- Validation:Valider le modèle affiné pour s’assurer qu’il répond aux critères de performance souhaités.

Meta Llama 3.1 405B : Tests de référence et performances

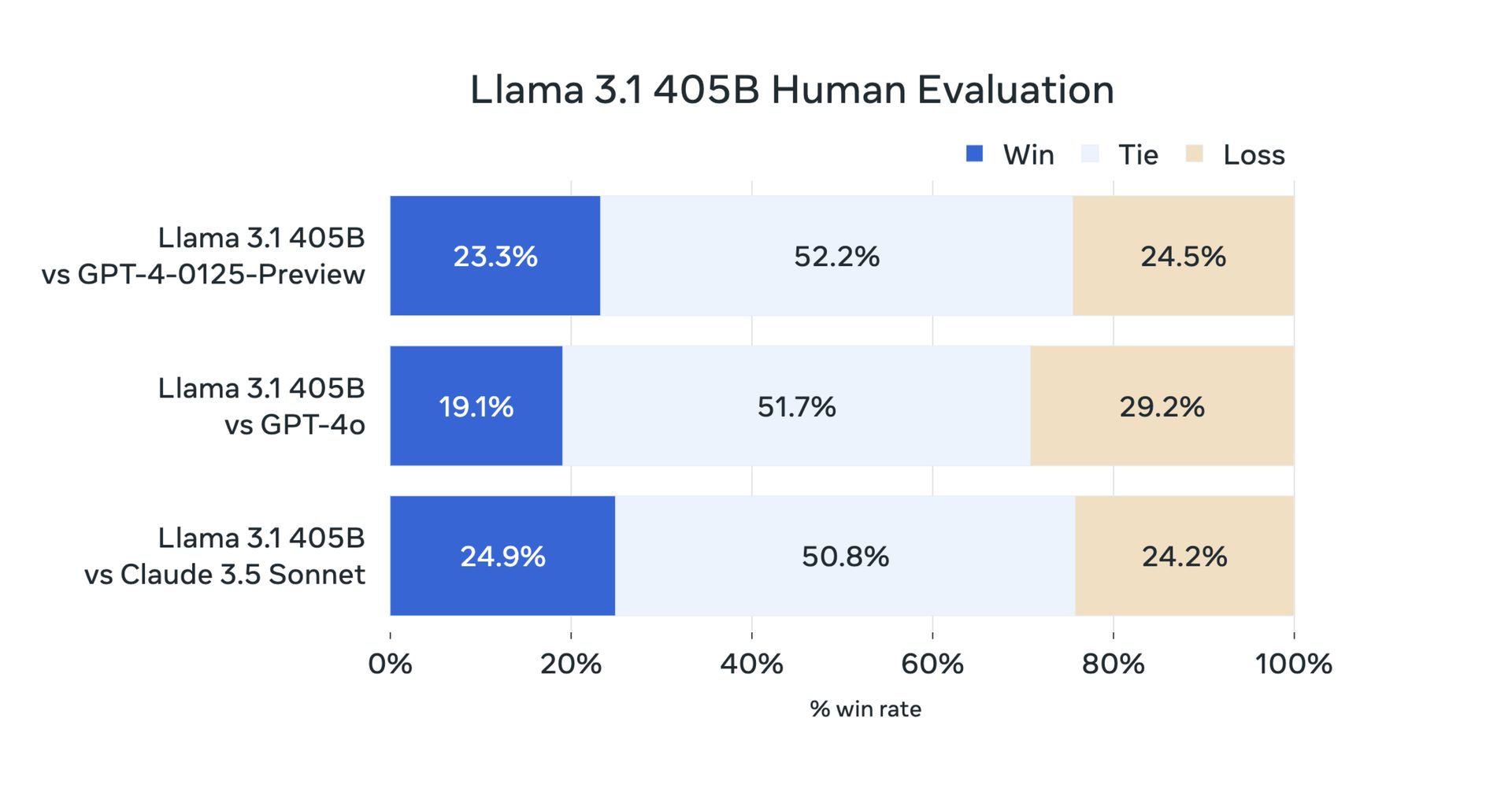

Hier, en raison de sa nature open source, les utilisateurs ont effectué leurs tests. Mais maintenant, les tests de référence officiels ont confirmé que Meta Llama 3.1 405B fonctionne exceptionnellement bien sur une variété de tâches. Le modèle a été évalué sur plus de 150 ensembles de données de référence et comparé à des modèles de pointe tels que GPT-4 et Claude 3.5 Sonnet. Les résultats montrent que Llama 3.1 405B est compétitif avec ces modèles haut de gamme et offre des performances de haute qualité dans des scénarios réels.

Tout d’abord, voici les benchmarks Llama 3.1 8B et Llama 3.1 70B :

| Catégorie | Référence | Lama 3.1 8B | Gemma 2 9B IT | Instructeur Mistral 7B | Lama 3.1 70B | Instructeur Mixtral 8x22B | GPT 3.5 Turbo |

|---|---|---|---|---|---|---|---|

| Général | MMLU (0 coup, CoT) | 73,0 | 72,3 | 60,5 | 86,0 | 79,9 | 69,8 |

| Général | MMLU PRO (5 coups, CoT) | 48.3 | – | 36,9 | 66,4 | 56.3 | 49.2 |

| Général | Évaluation de l’IFE | 80,4 | 73,6 | 57,6 | 87,5 | 72,7 | 69,9 |

| Code | HumanEval (0-shot) | 72,6 | 54.3 | 40.2 | 80,5 | 75,6 | 68,0 |

| Code | MBPP EvalPlus (base) (0 coup) | 72,8 | 71,7 | 49,5 | 86,0 | 78,6 | 82,0 |

| Mathématiques | GSM8K (8 prises, CoT) | 84,5 | 76,7 | 53.2 | 95,1 | 88,2 | 81,6 |

| Mathématiques | MATH (0 coup, CoT) | 51,9 | 44.3 | 13.0 | 68,0 | 54.1 | 43.1 |

| Raisonnement | Défi ARC (0 coup) | 83,4 | 87,6 | 74.2 | 94,8 | 88,7 | 83,7 |

| Raisonnement | GPQA (0 coup, CoT) | 32,8 | – | 28,8 | 46,7 | 33.3 | 30,8 |

| Utilisation de l’outil | BFCL | 76.1 | – | 60,4 | 84,8 | – | 85,9 |

| Utilisation de l’outil | Lien | 38,5 | 30.0 | 24,7 | 56,7 | 48,5 | 37.2 |

| Contexte long | ZeroSCROLLS/QUALITÉ | 81,0 | – | – | 90,5 | – | – |

| Contexte long | InfiniteBench/En.MC | 65.1 | – | – | 78.2 | – | – |

| Contexte long | NIH/Multi-aiguilles | 98,8 | – | – | 97,5 | – | – |

| Multilingue | MGSM multilingue (0-shot) | 68,9 | 53.2 | 29,9 | 86,9 | 71.1 | 51.4 |

Et il y a un benchmark Meta Llama 3.1 405B :

| Catégorie | Référence | Lama 3.1 405B | Instructeur Nemotron 4 340B | GPT-4 (0125) | GPT-4 Omni | Claude 3.5 Sonnet |

|---|---|---|---|---|---|---|

| Général | MMLU (0 coup, CoT) | 88,6 | 78,7 (hors CoT) | 85,4 | 88,7 | 88,3 |

| Général | MMLU PRO (5 coups, CoT) | 73,3 | 62,7 | 64,8 | 74,0 | 77,0 |

| Général | Évaluation de l’IFE | 88,6 | 85.1 | 84,3 | 85,6 | 88,0 |

| Code | HumanEval (0-shot) | 89,0 | 73,2 | 86,6 | 90,2 | 92,0 |

| Code | MBPP EvalPlus (base) (0 coup) | 88,6 | 72,8 | 83,6 | 87,8 | 90,5 |

| Mathématiques | GSM8K (8 prises, CoT) | 96,8 | 92,3 (0 coup) | 94,2 | 96,1 | 96,4 (0 coup) |

| Mathématiques | MATH (0 coup, CoT) | 73,8 | 41.1 | 64,5 | 76,6 | 71.1 |

| Raisonnement | Défi ARC (0 coup) | 96,9 | 94,6 | 96,4 | 96,7 | 96,7 |

| Raisonnement | GPQA (0 coup, CoT) | 51.1 | – | 41.4 | 53,6 | 59,4 |

| Utilisation de l’outil | BFCL | 88,5 | 86,5 | 88,3 | 80,5 | 90,2 |

| Utilisation de l’outil | Lien | 58,7 | – | 50.3 | 56.1 | 45,7 |

| Contexte long | ZeroSCROLLS/QUALITÉ | 95,2 | – | – | 90,5 | 90,5 |

| Contexte long | InfiniteBench/En.MC | 83,4 | – | 72.1 | 82,5 | – |

| Contexte long | NIH/Multi-aiguilles | 98,1 | – | 100,0 | 100,0 | 90,8 |

| Multilingue | MGSM multilingue (0-shot) | 91,6 | – | 85,9 | 90,5 | 91,6 |

Meta Llama 3.1 405B représente une avancée dans l’IA open source en fournissant aux développeurs et aux chercheurs un outil puissant pour une variété d’applications. Avec ses fonctionnalités avancées, son écosystème robuste et son engagement en faveur d’un développement responsable, nous espérons que Llama 3.1 405B apportera des innovations aux communautés d’IA 70B et 8B. Voici tout ce que nous avons préparé pour vous.

Crédits de l’image en vedette : Méta IA

Source: Tout ce que vous devez savoir sur Meta Llama 3.1 405B