La bande-annonce de Megalopolis est dans le pétrin après que certaines citations des critiques du film se soient révélées fausses et générées par l’IA. Eddie Egan, responsable du marketing de la bande-annonce, a été démis de ses fonctions à cause de ce désordre.

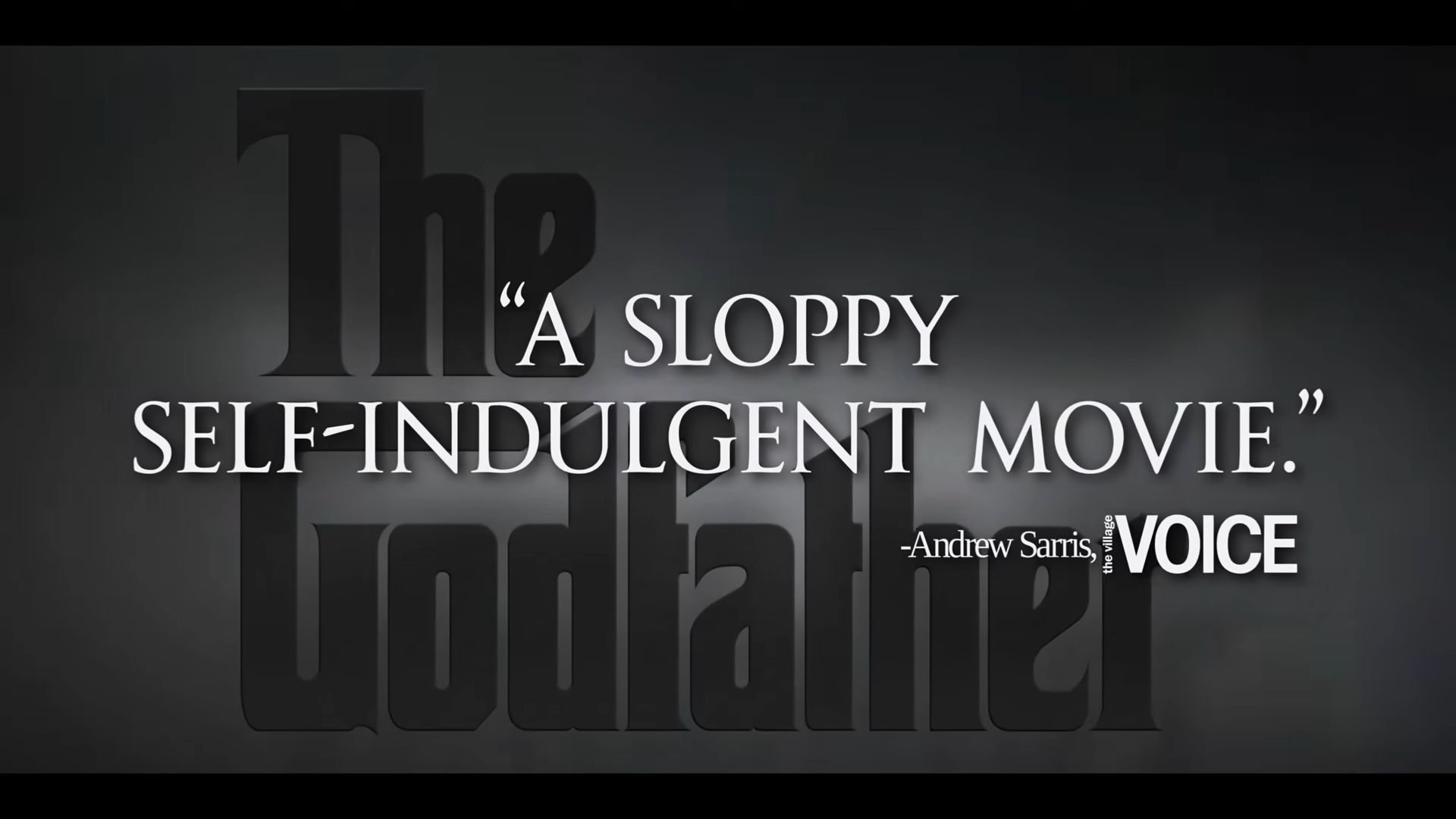

La bande-annonce contenait des critiques inventées qui critiquaient les films classiques de Francis Ford Coppola. Elle affirmait à tort que « Le Parrain » était un « film bâclé et complaisant » et qu’« Apocalypse Now » était « un film épique et nul ». En réalité, les critiques originales étaient positives et faisaient l’éloge des films.

Cette situation met en évidence un problème croissant de l’IA : elle peut avoir des hallucinations. Ce problème ne concerne pas uniquement les bandes-annonces de films. Les erreurs de l’IA ont également affecté des documents juridiques et des affaires judiciaires. Par exemple, l’avocat de Michael Cohen a soumis de faux dossiers judiciaires, et les avocats d’une compagnie aérienne colombienne ont commis des erreurs similaires. Même le rappeur Pras Michél a perdu un procès parce que son avocat a utilisé un argument généré par l’IA.

Que sont les hallucinations de l’IA ? Le scandale de la caravane Megalopolis montre comment elles fonctionnent

Les hallucinations liées à l’IA se produisent lorsque l’intelligence artificielle génère des informations qui semblent convaincantes mais qui sont en réalité fausses ou trompeuses. Le scandale de la bande-annonce de « Megalopolis » a mis ce terme sur le devant de la scène.

Dans ce cas, la bande-annonce contenait de fausses citations de critiques sur les films de Francis Ford Coppola, affirmant que « Le Parrain » était « bâclé » et qu’« Apocalypse Now » était « un morceau de merde épique ». L’IA a créé ces citations, mais elles ne correspondaient pas aux critiques positives réelles de ces films. L’IA a « halluciné » ces citations, produisant des déclarations crédibles mais fausses.

Les hallucinations de l’IA se produisent parce que la technologie peut générer du texte en fonction de modèles qu’elle a appris à partir de données, mais ne comprend pas vraiment le contenu. Elle peut mélanger les faits, créer des erreurs ou inventer des choses entièrement nouvelles, comme c’est arrivé avec les critiques trompeuses dans la bande-annonce.

Cet incident met en évidence les risques que comporte le recours à l’IA sans contrôles appropriés. Tout comme dans l’affaire « Megalopolis », où de fausses citations ont entraîné de graves conséquences pour les personnes impliquées, les hallucinations de l’IA peuvent provoquer confusion et dommages si elles ne sont pas gérées avec soin. Cela nous rappelle que si l’IA peut être puissante, il est essentiel de vérifier ses résultats pour éviter de diffuser des informations trompeuses.

Crédits de l’image en vedette : IMDB

Source: Si vous utilisez l’IA de cette façon, vous perdrez votre emploi