OpenAI a lancé des fonctionnalités vidéo en temps réel pour ChatGPT, intégrant des fonctionnalités visuelles dans son mode vocal avancé. Cette annonce a été faite lors d’un événement diffusé en direct le 12 décembre 2024. La version mise à jour peut reconnaître des objets en temps réel via la caméra de l’appareil de l’utilisateur, traiter des informations visuelles via le partage d’écran et engager des conversations de type humain. Disponible pour les abonnés de ChatGPT Plus, Team et Pro, la mise à jour sera déployée au cours de la semaine prochaine, certains utilisateurs de l’UE étant confrontés à des retards potentiels.

Grâce à cette amélioration, ChatGPT peut répondre aux utilisateurs en interprétant ce qu’il voit, par exemple en proposant des explications sur les paramètres d’un appareil ou en fournissant des suggestions pour résoudre des problèmes mathématiques. Pour utiliser ces fonctionnalités, les utilisateurs peuvent appuyer sur l’icône vocale dans l’application ChatGPT et activer le partage vidéo ou d’écran. Le déploiement est prioritaire pour les abonnés Plus, tandis que les utilisateurs ChatGPT Enterprise et Edu y auront accès en janvier 2025.

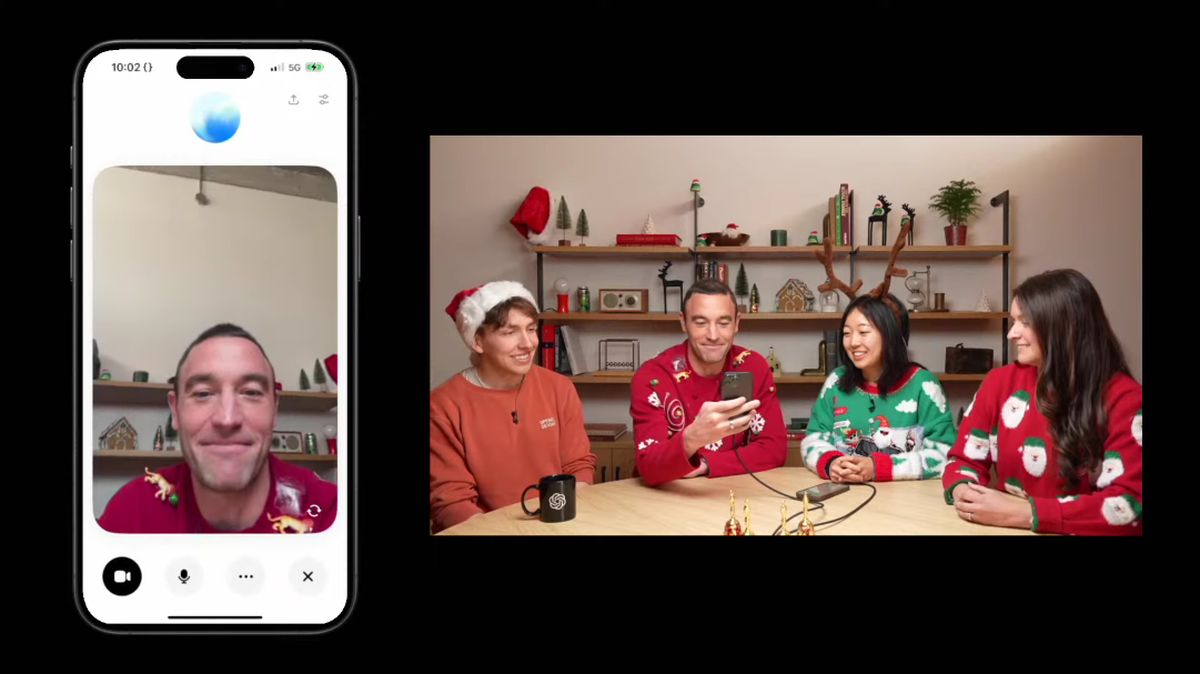

OpenAI présente des fonctionnalités avancées dans une démonstration en direct

Lors de la récente démonstration en direct, le président d’OpenAI, Greg Brockman, a souligné les capacités attrayantes du mode vocal avancé avec vision. Brockman a interrogé Anderson Cooper de CNN sur l’anatomie tout en démontrant comment ChatGPT pouvait comprendre et commenter les dessins réalisés par Cooper sur un tableau noir. L’interaction a illustré le potentiel d’un apprentissage et d’un feedback interactifs en temps réel, bien que ChatGPT ait présenté certaines erreurs, telles qu’un mauvais calcul d’un problème de géométrie, soulignant les défis persistants liés à la précision du modèle.

Cette fonctionnalité mise à jour a connu des retards de développement, OpenAI ayant déjà fait allusion à des fenêtres de lancement qui ont finalement été étendues. Démonstré initialement en mai 2024, le mode vocal avancé devait arriver plus tôt. L’annonce récente met en valeur l’aboutissement des efforts visant à affiner et finaliser cette capacité, indiquant une orientation stratégique sur l’amélioration de l’expérience utilisateur et des capacités technologiques du chatbot.

En plus des nouvelles fonctionnalités visuelles, OpenAI a également dévoilé un « Mode Père Noël » pour les fêtes de fin d’année, permettant aux utilisateurs d’interagir avec ChatGPT sur un ton festif. Pour accéder à cette fonctionnalité, les utilisateurs peuvent cliquer sur l’icône en forme de flocon de neige dans l’application. Cette option saisonnière réinitialise les limites d’utilisation pour l’interaction initiale, offrant ainsi aux utilisateurs davantage de possibilités de participer à la fonctionnalité festive.

Des concurrents tels que Google et Meta développent des fonctionnalités similaires, comme le projet Astra de Google, qui a récemment été mis à la disposition de testeurs sélectionnés sur Android. Ces efforts reflètent une tendance plus large selon laquelle les grandes entreprises technologiques s’efforcent d’intégrer des fonctionnalités vidéo interactives dans leurs modèles d’IA, améliorant ainsi l’engagement des utilisateurs et la polyvalence des applications.

OpenAI a également indiqué son intention de déployer d’autres améliorations, telles que le renforcement de son programme de recherche sur le réglage fin du renforcement, conçu pour optimiser les performances des modèles dans des tâches spécialisées. Ce programme s’adresse aux instituts de recherche et aux entreprises, leur permettant de personnaliser les modèles OpenAI pour des applications complexes.

Crédit image en vedette : OpenAI

Le message OpenAI lance des fonctionnalités vidéo en temps réel pour ChatGPT apparaît en premier sur TechBriefly.

Source: OpenAI lance des fonctionnalités vidéo en temps réel pour ChatGPT