Nvidia révolutionne le monde de l’informatique à intelligence artificielle avec le récent lancement du NVIDIA H200. Cette plateforme de pointe, construite sur la trémie NVIDIA architecture, dispose du puissant GPU NVIDIA H200 Tensor Core, équipé de mémoire avancée conçu pour s’attaquer charges de données importantes pour les charges de travail d’IA générative et de calcul haute performance (HPC).

architecture, dispose du puissant GPU NVIDIA H200 Tensor Core, équipé de mémoire avancée conçu pour s’attaquer charges de données importantes pour les charges de travail d’IA générative et de calcul haute performance (HPC).

Dans cet article, nous approfondirons le lancement récent et fournirons autant de détails que possible sur le nouveau NVIDIA H200.

La puissance du NVIDIA H200

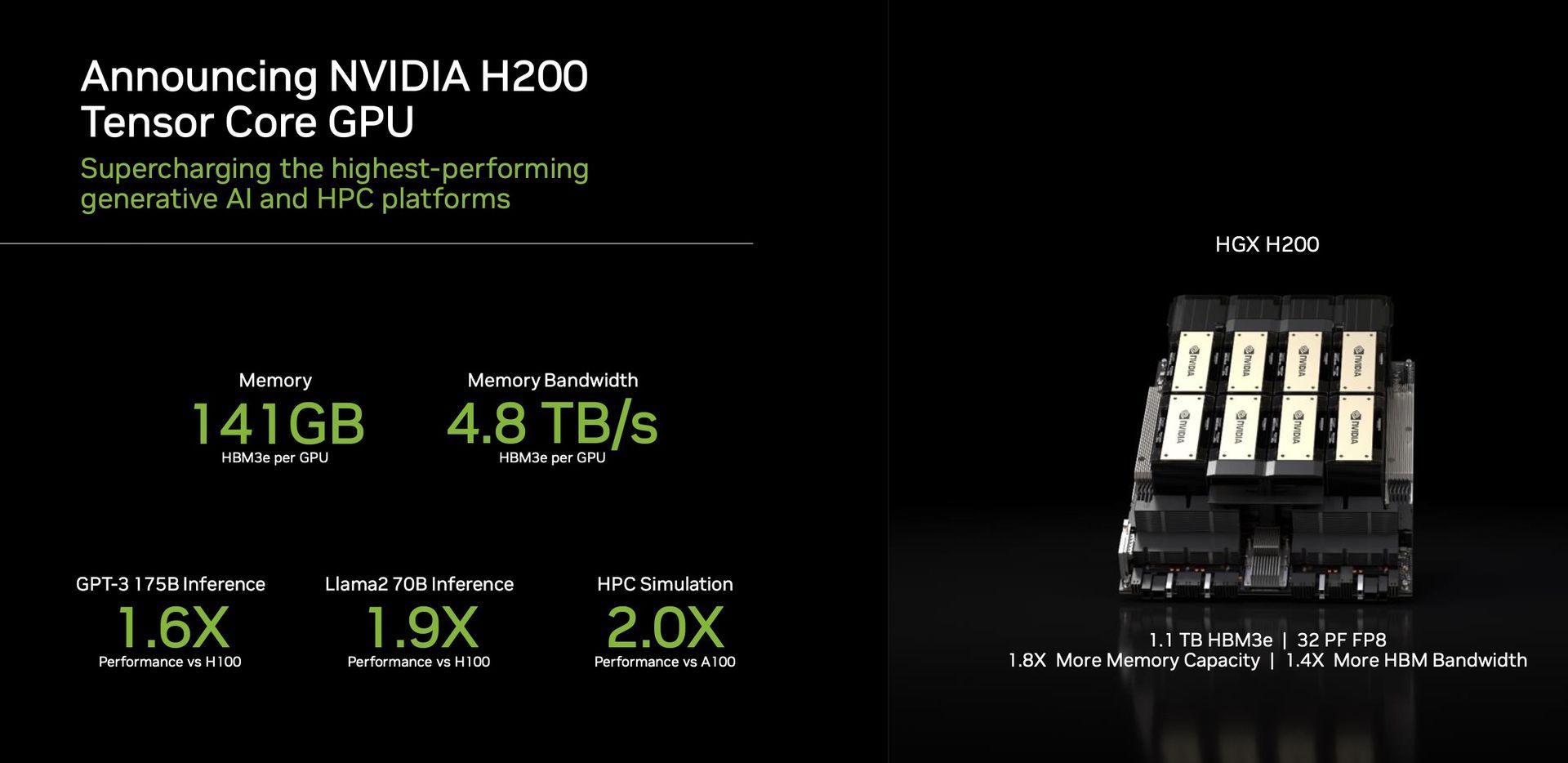

Une caractéristique remarquable du H200 est son utilisation de HBM3e, le premier GPU à offrir cette mémoire plus rapide et plus grande. Cette avancée propulse l’accélération de l’IA générative et des grands modèles de langage, repoussant simultanément les limites de calcul scientifique pour les charges de travail HPC. Avec HBM3e, le H200 offre un impressionnant 141 Go de mémoire à un rythme stupéfiant 4,8 téraoctets par seconde. Cela représente presque le double de la capacité et 2,4 fois plus de bande passante par rapport à son prédécesseur, le NVIDIA A100.

Performances et applications

Le H200, propulsé par NVIDIA NVLink et NVSwitch

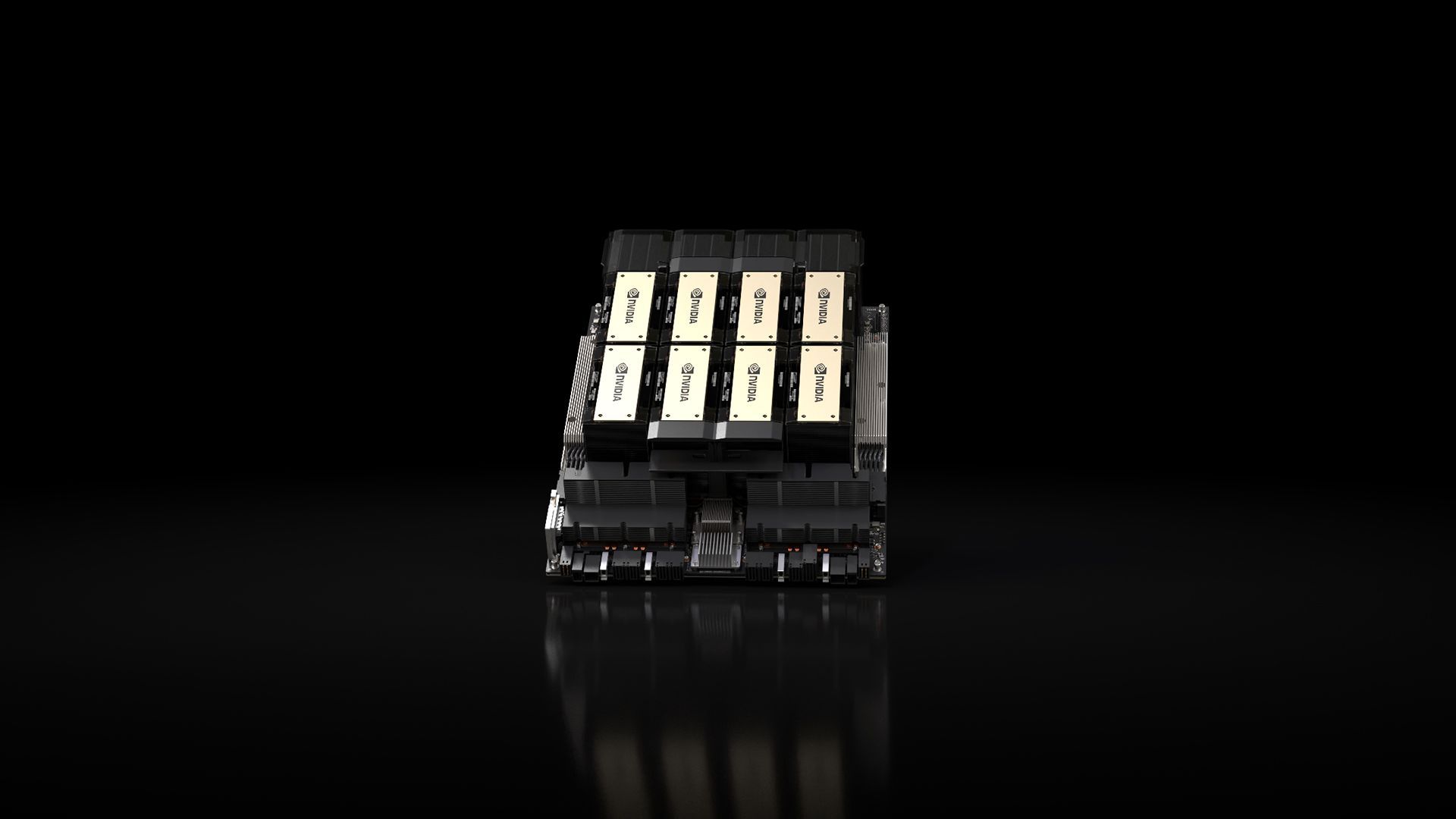

et NVSwitch interconnexions à haut débit, promesses des performances inégalées sur diverses charges de travail d’application. Cela inclut ses prouesses en matière de formation LLM (Large Language Model) et d’inférence pour des modèles dépassant un niveau colossal. 175 milliards de paramètres. Un HGX H200 à huit voies se démarque en offrant plus de 32 pétaflops de FP8 de profondeur apprentissage du calcul et une mémoire globale à large bande passante de 1,1 To, garantir des performances optimales dans les applications génératives d’IA et HPC.

interconnexions à haut débit, promesses des performances inégalées sur diverses charges de travail d’application. Cela inclut ses prouesses en matière de formation LLM (Large Language Model) et d’inférence pour des modèles dépassant un niveau colossal. 175 milliards de paramètres. Un HGX H200 à huit voies se démarque en offrant plus de 32 pétaflops de FP8 de profondeur apprentissage du calcul et une mémoire globale à large bande passante de 1,1 To, garantir des performances optimales dans les applications génératives d’IA et HPC.

Les GPU de Nvidia sont devenus pivot dans le domaine des modèles d’IA générative, jouant un rôle crucial dans leur développement et leur déploiement. Conçus pour gérer les calculs parallèles massifs requis pour la formation et l’exécution de ces modèles, les GPU de Nvidia excellent dans des tâches telles que génération d’images et langage naturel traitement. L’architecture de traitement parallèle permet à ces GPU d’effectuer de nombreux calculs simultanément, ce qui entraîne une accélération substantielle des processus de modèles d’IA génératifs.

Le H200 témoigne de l’engagement de Nvidia à innovation perpétuelle et bonds de performance. S’appuyant sur le succès de l’architecture Hopper, des améliorations logicielles continues, y compris la publication récente de bibliothèques open source comme NVIDIA TensorRT -LLM, continuer à améliorer les performances de la plateforme. L’introduction de NVIDIA H200 promet de nouveaux progrès, avec des attentes de près de doubler la vitesse d’inférence sur des modèles comme Llama 2, un LLM de 70 milliards de paramètres, par rapport à son prédécesseur, le H100.

-LLM, continuer à améliorer les performances de la plateforme. L’introduction de NVIDIA H200 promet de nouveaux progrès, avec des attentes de près de doubler la vitesse d’inférence sur des modèles comme Llama 2, un LLM de 70 milliards de paramètres, par rapport à son prédécesseur, le H100.

Polyvalence et disponibilité

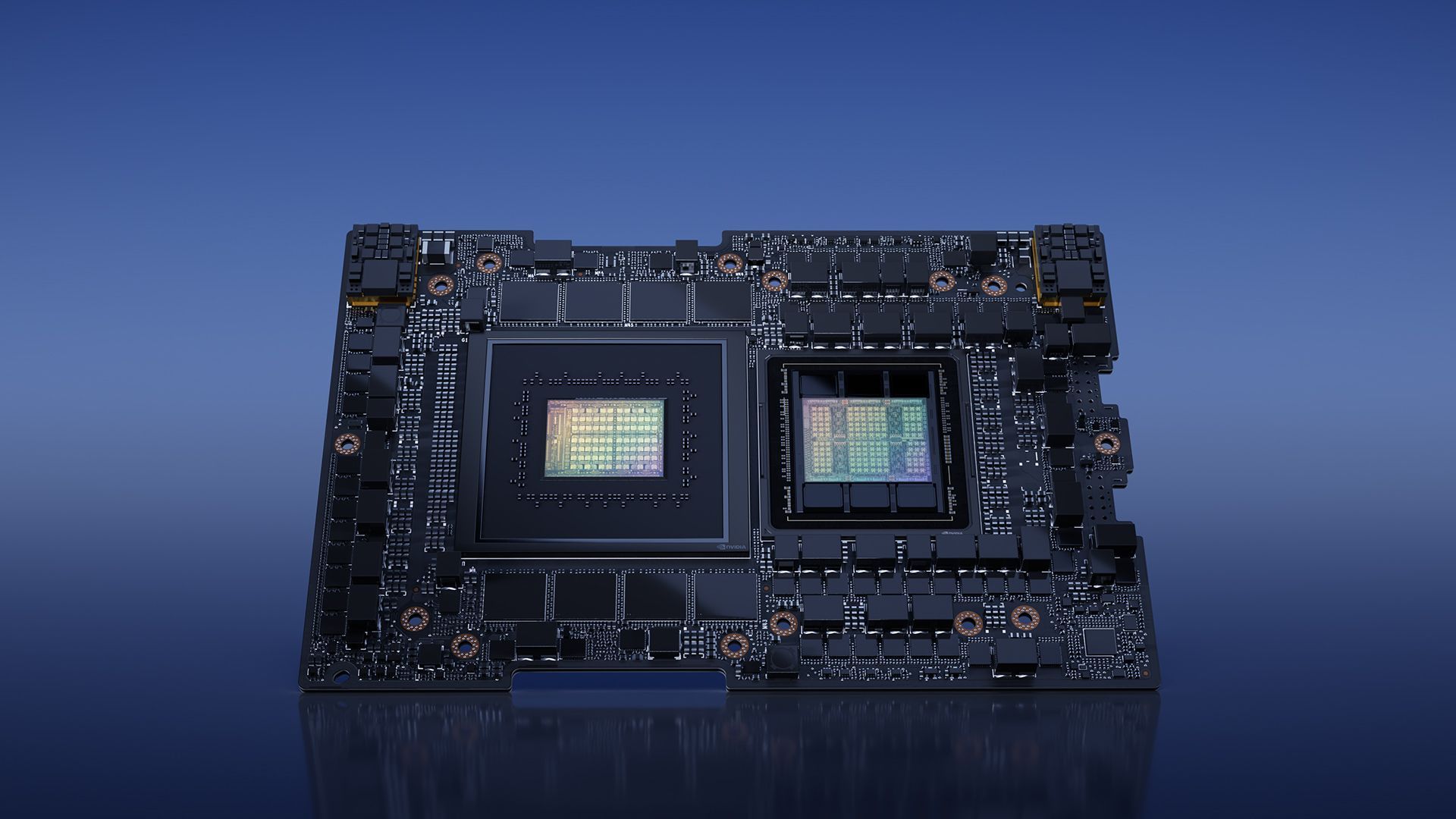

Nvidia assure Polyvalence avec le H200, en le proposant sous différents facteurs de forme, tels que les cartes serveurs NVIDIA HGX H200 avec des configurations à quatre et huit voies. Ces configurations sont compatibles avec le matériel et les logiciels des systèmes HGX H100. De plus, NVIDIA H200 est disponible en le NVIDIA GH200 Grace Hopper Superchip avec HBM3e, adapté à différentes configurations de centres de données, y compris les environnements sur site, cloud, cloud hybride et Edge. L’écosystème mondial des fabricants de serveurs partenaires peut mettre à jour en toute transparence leurs systèmes existants avec le H200, garantissant une accessibilité généralisée.

Superchip avec HBM3e, adapté à différentes configurations de centres de données, y compris les environnements sur site, cloud, cloud hybride et Edge. L’écosystème mondial des fabricants de serveurs partenaires peut mettre à jour en toute transparence leurs systèmes existants avec le H200, garantissant une accessibilité généralisée.

Les passionnés et les experts du secteur attendent avec impatience la sortie des systèmes HGX H200, qui devraient arriver sur le marché en le deuxième trimestre 2024. Des acteurs mondiaux de premier plan tels que Services Web Amazon, Google Cloud, Microsoft Azure, et Infrastructure cloud Oracle sont parmi la première vague de fournisseurs de services cloud prêt à déployer des instances basées sur H200 l’année prochaine.

architecture (Crédit image)

architecture (Crédit image)En conclusion, le NVIDIA H200, avec ses fonctionnalités et performances révolutionnaires, est destiné à redéfinir le paysage de l’informatique IA. Dès qu’il sera disponible au deuxième trimestre 2024, le H200 est sur le point de permettre aux développeurs et aux entreprises du monde entier, accélérer le développement et le déploiement d’applications d’IA de la parole à l’inférence hyperscale.

En attendant, si vous êtes intéressé par la société technologique leader, n’oubliez pas de consulter également notre article sur la façon dont Nvidia et AMD travaillent sur une « puce basée sur un bras ».

Crédit image en vedette : Nvidia

Source: NVIDIA H200 est introduit avec une grande anticipation dans le domaine de l’IA