Nvidia Grace CPU et Nvidia H100 ont été dévoilés à Nvidia GTC 2022. Nvidia a annoncé aujourd’hui son architecture GPU Hopper de nouvelle génération et son GPU Hopper H100, ainsi qu’une nouvelle puce de centre de données qui combine le GPU avec un CPU hautes performances, surnommé le ” Grace CPU Superchip” (à ne pas confondre avec les autres Grâce superpuce).

Processeur Nvidia Grace : spécifications, prix et date de sortie

Le Nvidia GPU Superchip est la première tentative de la société pour un processeur spécialisé dans les centres de données. La puce basée sur Arm comportera 144 cœurs stupéfiants et 1 téraoctet par seconde de bande passante mémoire, selon les informations divulguées par Intel. Il combine en fait deux processeurs Grace connectés via l’interconnexion NVLink de Nvidia, qui est comparable à l’architecture M1 Ultra d’Apple.

Le nouveau CPU, qui sera alimenté par une mémoire LPDDR5X rapide, devrait être livré au premier semestre 2023 et offrira 2 fois les performances des serveurs conventionnels. Nvidia prédit que la puce atteindra 740 points sur le benchmark SPECrate®2017_int_base, la plaçant face à face avec les processeurs de centre de données AMD et Intel haut de gamme (bien que certains d’entre eux obtiennent des scores plus élevés, mais au prix de performances inférieures par watt ).

« Un nouveau type de centre de données a émergé : des usines d’IA qui traitent et affinent des montagnes de données pour produire de l’intelligence. Le Grace CPU Superchip offre les performances, la bande passante mémoire et les plates-formes logicielles NVIDIA les plus élevées dans une seule puce et brillera en tant que CPU de l’infrastructure IA mondiale.

-Jensen Huang, fondateur et PDG de Nvidia

Cette nouvelle puce, à bien des égards, est la progression naturelle de la super puce et du processeur Grace Hopper annoncés l’année dernière. le Superpuce Grace Hopper combine un CPU et un GPU dans une seule conception de système sur puce. Ce système, qui fera également ses débuts au premier semestre 2023, comprendra un GPU de 600 Go de mémoire pour les gros modèles et Nvidia affirme que la bande passante mémoire sera 30 fois supérieure au GPU d’un serveur de base. Ces processeurs, selon Nvidia, sont destinés à des applications d’IA et de calcul haute performance « à grande échelle ».

Le Grace CPU Superchip est un SoC basé sur Arm v9 qui peut être utilisé pour créer des CPU ou des serveurs autonomes avec jusqu’à huit GPU basés sur Hopper.

La société indique qu’elle travaille avec “des clients leaders du HPC, du supercalcul, de l’hyperscale et du cloud”, ce qui implique que ces systèmes seront éventuellement disponibles sur un fournisseur de cloud près de chez vous.

Aucune information sur le prix n’a encore été partagée.

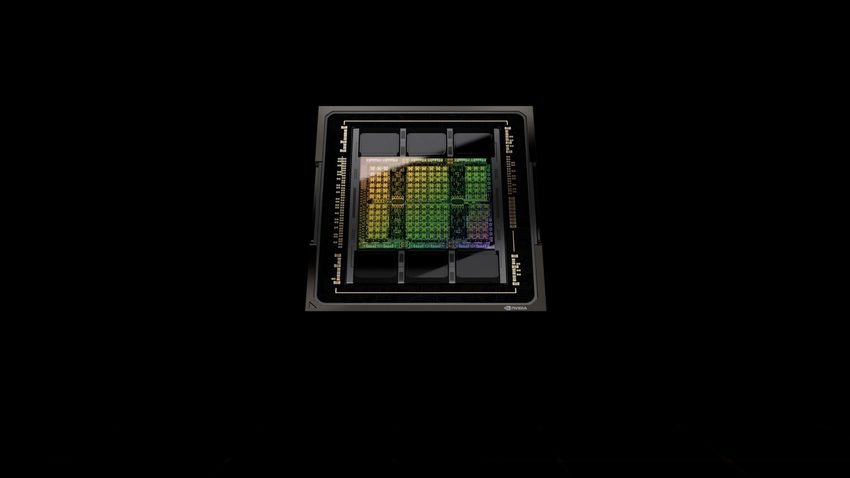

GPU Nvidia H100 : spécifications, prix et date de sortie

Nvidia lance un certain nombre de technologies nouvelles et améliorées avec Hopper, mais l’accent mis par l’architecture sur les modèles de transformateurs, qui sont devenus la technique d’apprentissage automatique de choix pour de nombreuses applications et qui alimentent des modèles comme GPT-3 et asBERT, peut être le plus essentiel. .

Le nouveau Transformer Engine de la puce H100 promet d’accélérer la formation des modèles jusqu’à six fois, et parce que cette nouvelle architecture comprend également le nouveau système NVLink Switch de Nvidia pour relier de nombreux nœuds, les clusters de serveurs massifs alimentés par ces puces pourront évoluer pour prendre en charge d’énormes réseaux avec moins de frais généraux.

« Les plus grands modèles d’IA peuvent nécessiter des mois pour s’entraîner sur les plates-formes informatiques d’aujourd’hui. C’est trop lent pour les entreprises. L’intelligence artificielle, le calcul haute performance et l’analyse de données deviennent de plus en plus complexes, certains modèles, comme les grands langages, atteignant des billions de paramètres. L’architecture NVIDIA Hopper est conçue à partir de zéro pour accélérer ces charges de travail d’IA de nouvelle génération avec une puissance de calcul massive et une mémoire rapide pour gérer des réseaux et des ensembles de données en pleine croissance.

-Dave Salvator

Les cœurs Tensor des clients, qui peuvent combiner une précision de 8 bits et une demi-précision de 16 bits selon les besoins tout en restant précis, sont utilisés dans le nouveau Moteur de transformateur.

Aucune information sur le prix n’a encore été partagée.