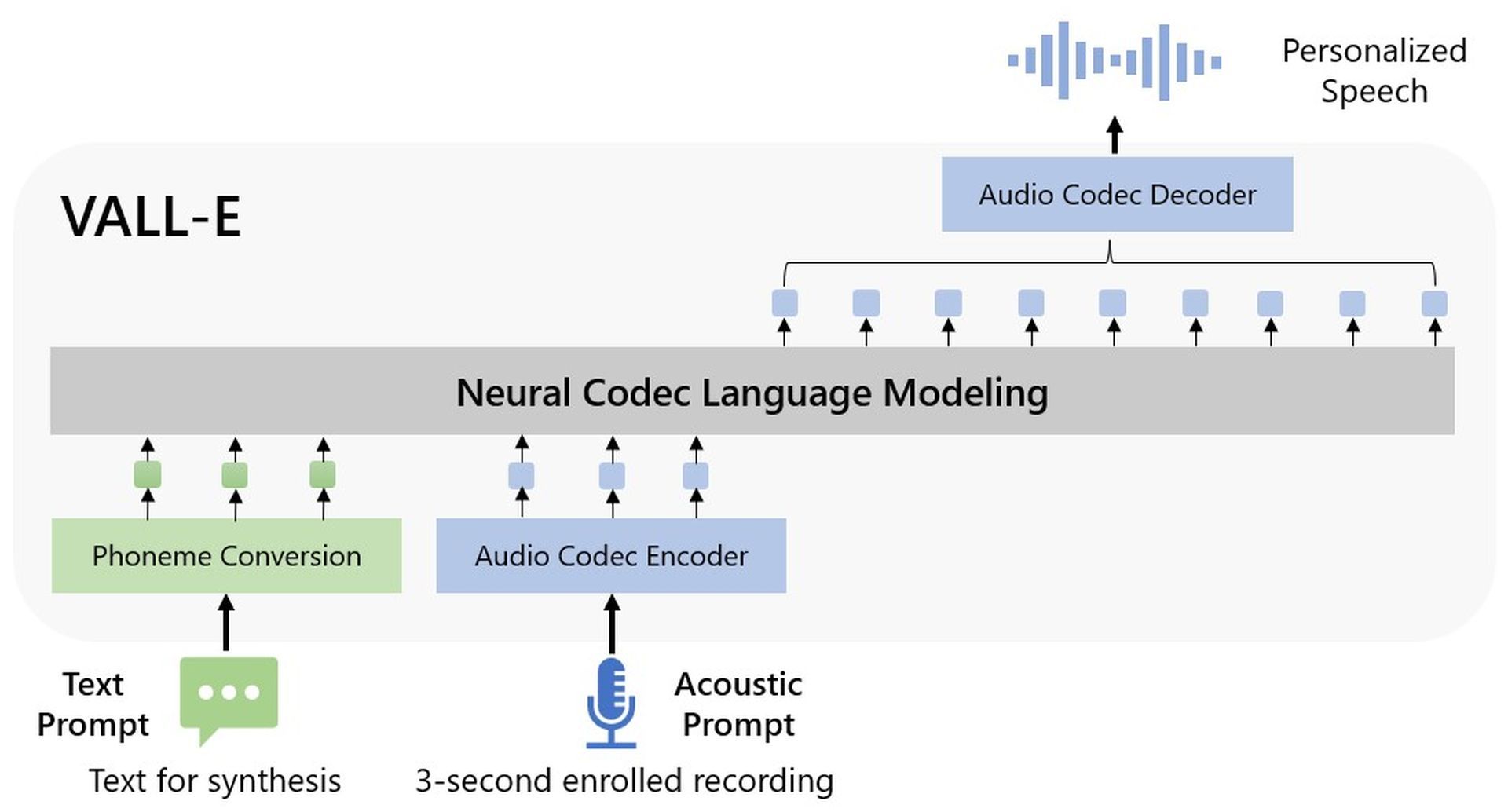

Le point de vue de Microsoft sur la synthèse vocale, Microsoft VALL-E a été annoncé dans un article publié par la société. Le modèle audio ne nécessite qu’un fichier audio de 3 secondes pour traiter l’entrée donnée.

Microsoft VALL-E, une nouvelle approche de modèle de langage pour la synthèse vocale (TTS) qui exploite les codes de codec audio comme représentations intermédiaires, vient d’être lancée par Microsoft. Il a été pré-entraîné sur 60 000 heures de données vocales en anglais, puis a affiché des capacités d’apprentissage en contexte dans des circonstances nulles.

Microsoft VALL-E peut produire un discours personnalisé de haute qualité avec seulement un enregistrement inscrit de trois secondes d’un locuteur oblique agissant comme un stimulus acoustique. Il le fait sans avoir besoin d’une ingénierie structurelle supplémentaire, de caractéristiques acoustiques préconçues ou d’un réglage fin. Il prend en charge l’apprentissage contextuel et les approches TTS instantanées basées sur des invites. Il semble que la mise à l’échelle des données semi-supervisées pour TTS a été sous-utilisée car Microsoft a utilisé une quantité importante de données semi-supervisées pour construire un système TTS généralisé dans la dimension du locuteur.

Que pouvez-vous faire avec Microsoft VALL-E ?

Selon les chercheurs, Microsoft VALL-E est un “modèle de langage de codec neuronal” qui a été formé à l’aide de codes discrets “dérivés d’un modèle de codec audio neuronal préexistant”. Il a été formé sur 60 000 heures de parole, ce qui est “des centaines de fois plus que les systèmes existants”, selon le communiqué. Ces exemples sont convaincants contrairement aux tentatives antérieures qui sont très évidemment des robots, même si l’IA existe depuis un certain temps et peut imiter de manière réaliste la parole humaine.

Microsoft VALL-E peut “préserver l’émotion et l’environnement auditif de l’orateur”, selon les chercheurs, de l’invite. Même si elle est impressionnante, la technologie est encore loin de remplacer les acteurs de la voix car trouver le ton et l’émotion appropriés lors d’une représentation est différent. Même une version avancée de Microsoft VALL-E ne serait pas aussi performante qu’un professionnel qualifié, mais les entreprises privilégient souvent la rentabilité à la qualité.

Au La démo GitHub de Microsoftvous pouvez écouter certains des échantillons.

Fonctionnalités Microsoft VALL-E

Bien que Microsoft VALL-E soit très nouveau, il possède déjà de nombreuses fonctionnalités.

Synthèse de la diversité: étant donné que Microsoft VALL-E génère des jetons discrets à l’aide de la technique basée sur l’échantillonnage, sa sortie varie pour le même texte d’entrée. Il peut donc synthétiser différents échantillons de parole personnalisés en utilisant une variété de graines aléatoires.

Entretien de l’environnement acoustique: Microsoft VALL-E peut fournir un discours personnalisé tout en conservant l’environnement acoustique de l’invite du haut-parleur. Par rapport à la ligne de base, VALL-E est formé sur un grand ensemble de données avec plus de variables acoustiques. L’audio et les transcriptions ont été produites à l’aide d’échantillons de l’ensemble de données Fisher.

Entretien des émotions du locuteur: En utilisant la base de données des voix émotionnelles comme ressource, par exemple des invites audio, Microsoft VALL-E peut créer un discours personnalisé tout en conservant la teneur émotionnelle de l’invite du haut-parleur. Les approches traditionnelles entraînent un modèle en corrélant la parole à la transcription et à une étiquette d’émotion dans un ensemble de données TTS émotionnel supervisé. VALL-E peut garder l’émotion dans l’invite même dans une situation de tir nul.

Microsoft VALL-E a toujours des problèmes avec la structure du modèle, la couverture des données et la robustesse de la synthèse.

Comment fonctionne Microsoft WALL-E ?

Microsoft a utilisé LibriLight, une bibliothèque audio créée par Meta, pour former les compétences de synthèse de VALL-voice E. La majorité des 60 000 heures de discours en anglais sont tirées des livres audio du domaine public LibriVox et sont parlées par plus de 7 000 personnes différentes. La voix dans l’échantillon de trois secondes doit ressembler étroitement à une voix dans les données d’apprentissage pour VALL-E pour obtenir un résultat satisfaisant.

Microsoft propose des dizaines d’exemples audio du modèle AI en action sur la page d’exemple VALL-E. Le “Speaker Prompt”, l’un des échantillons, correspond aux trois secondes d’audio que VALL-E est chargé d’imiter. La « vérité au sol » est un extrait enregistré précédemment de cet orateur qui est utilisé comme référence (un peu comme le « contrôle » dans l’expérience). L’échantillon “VALL-E” est la sortie du modèle VALL-E, et l’échantillon “Baseline” est un exemple de synthèse produite par une approche traditionnelle de synthèse texte-parole.

Alors que Microsoft VALL-E est entré dans l’histoire en tant que premier, mais certainement pas le dernier, grand projet d’IA de 2023, le géant de la technologie a soutenu financièrement OpenAI Point-E, qui a été publié dans les dernières semaines de 2022.

Source: Microsoft VALL-E expliqué : Une voix DALL-E