Maia 100 de Microsoft est un accélérateur d’IA personnalisé conçu pour révolutionner la façon dont les charges de travail d’IA sont exécutées dans le cloud.

La demande d’applications basées sur l’IA ne cesse de croître, et il existe un besoin croissant de matériel capable de gérer les énormes exigences de calcul de ces charges de travail. Maia a été spécialement conçu pour répondre à ce besoin, offrant des performances, une efficacité et une évolutivité exceptionnelles.

Qu’est-ce que la puce Microsoft Maia 100 ?

Maia 100 est une puce accélératrice d’IA personnalisée développée par Microsoft. Elle est conçue pour accélérer l’exécution des charges de travail d’IA dans le cloud. Maia 100 est basée sur une nouvelle architecture spécifiquement optimisée pour les charges de travail d’IA.

Cette architecture comprend une unité tensorielle à grande vitesse, un processeur vectoriel et un moteur DMA.

Qu’est-ce qui rend Maia 100 spécial ?

Maia 100 est un accélérateur d’IA hautement spécialisé qui offre plusieurs avantages clés :

Haute performance

Maia 100 est conçu pour exceller dans la gestion d’un large éventail de charges de travail d’IA, du traitement du langage naturel à la vision par ordinateur et bien plus encore. Ses performances exceptionnelles sont attribuées à :

- Puissance thermique nominale élevée (TDP) : Maia 100 peut gérer jusqu’à 700 W de puissance, ce qui lui permet d’effectuer des tâches d’IA complexes sans surchauffe ni limitation.

- Large bande passante : La puce offre une bande passante totale de 1,8 téraoctet par seconde, ce qui garantit une circulation fluide et efficace des données entre le processeur et la mémoire. Cela est essentiel pour les charges de travail d’IA qui impliquent souvent de grands ensembles de données.

Efficacité

Maia 100 est conçu pour être économe en énergie, un facteur essentiel pour réduire les coûts d’exploitation et l’impact environnemental. Cette efficacité est obtenue grâce à :

- Type de données de stockage de faible précision : En utilisant un type de données de moindre précision, Maia 100 peut réduire la quantité de mémoire requise pour les calculs, ce qui améliore l’efficacité énergétique.

- Moteur de compression de données : La puce intègre un moteur de compression de données qui peut réduire la taille des données, améliorant ainsi encore l’efficacité et réduisant les besoins en bande passante.

Évolutivité

Maia 100 est conçu pour évoluer afin de répondre aux exigences croissantes des charges de travail de l’IA. Cette évolutivité est rendue possible par :

- Interconnexions basées sur Ethernet : Maia 100 prend en charge les interconnexions Ethernet à large bande passante, ce qui lui permet d’être facilement intégré dans des clusters d’IA à grande échelle. Cela permet une communication et un transfert de données transparents entre plusieurs puces Maia 100.

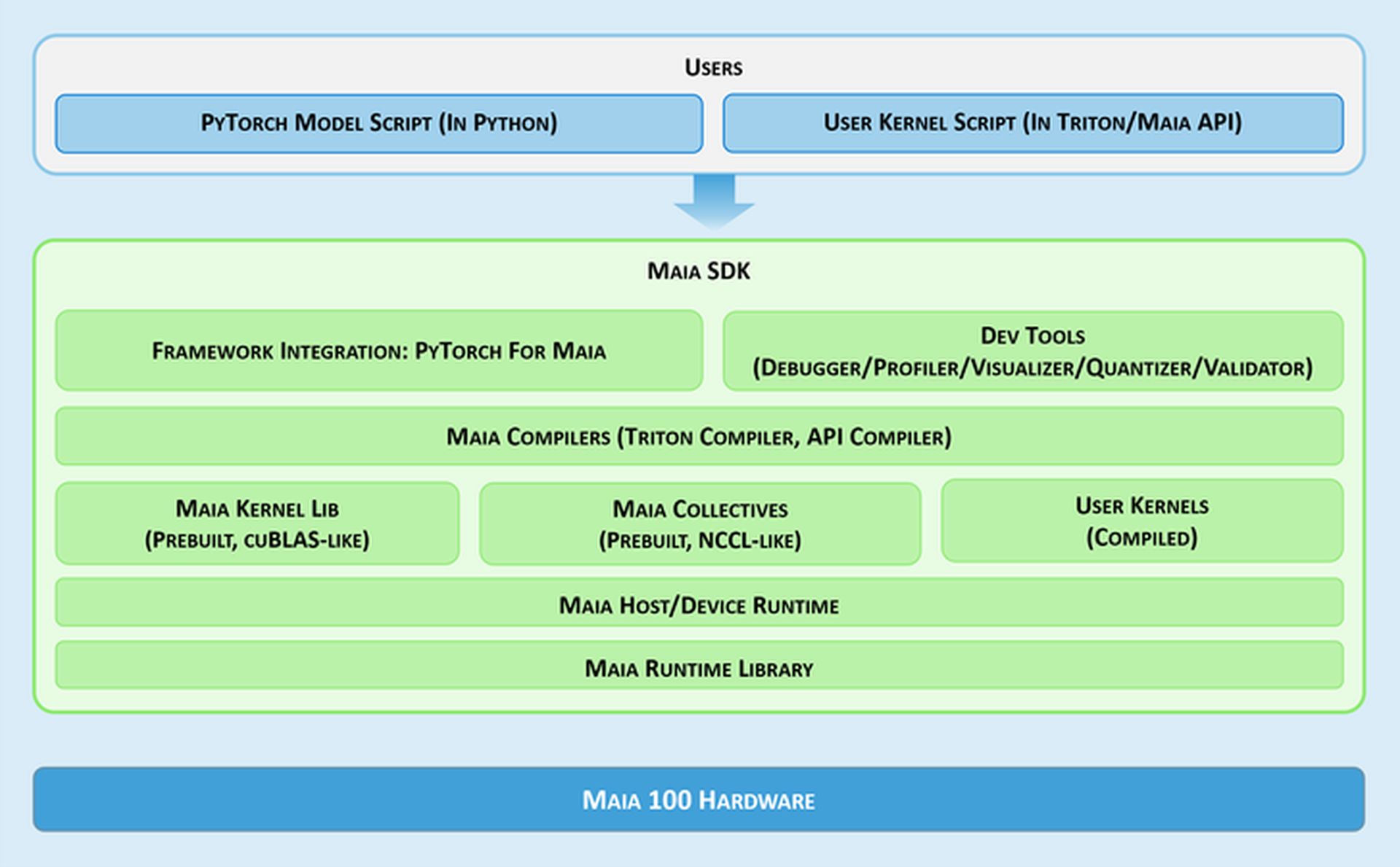

Outils de développement

Pour faciliter le développement et le déploiement d’applications d’IA sur Maia, Microsoft fournit un kit de développement logiciel (SDK) complet. Ce SDK comprend une gamme d’outils qui peuvent aider les développeurs à :

- Déboguer: Identifier et corriger les erreurs dans leurs modèles d’IA.

- Profil: Analysez les performances de leurs modèles d’IA pour identifier les goulots d’étranglement et optimiser le code.

- Visualiser: Visualisez le comportement de leurs modèles d’IA pour obtenir des informations sur leurs performances.

- Quantifier et valider : Convertissez les modèles d’IA en formats de moindre précision pour améliorer l’efficacité et valider leur précision.

Ces outils permettent aux développeurs d’utiliser efficacement les capacités de Maia 100 et de créer des applications d’IA hautes performances.

Le marché est chaud !

Le marché du matériel d’IA est très concurrentiel, avec plusieurs acteurs majeurs en compétition pour conquérir des parts de marché. Voici quelques-uns des principaux concurrents de Maia 100 :

- NVIDIA : NVIDIA est un fournisseur leader de matériel d’IA, ses GPU des séries Tesla et RTX étant largement utilisés pour les charges de travail d’IA.

- Renseignements : Intel propose une gamme d’accélérateurs d’IA, notamment les processeurs Habana Gaudi et Intel Xeon Scalable.

- DMLA : AMD est un autre acteur majeur sur le marché du matériel d’IA, avec ses GPU Radeon Instinct et ses CPU EPYC.

- TPU de Google : L’unité de traitement tenseur (TPU) de Google est un accélérateur d’IA personnalisé conçu pour les charges de travail d’apprentissage automatique.

- Graphcore: Graphcore est une société britannique de semi-conducteurs spécialisée dans les accélérateurs d’IA conçus pour les réseaux de neurones graphiques.

- Systèmes Cérébraux : Cerebras Systems est une société basée aux États-Unis qui propose le CS-2, un système informatique d’IA à grande échelle.

Ce ne sont là que quelques-uns des principaux concurrents de Maia. Le marché du matériel d’IA est en constante évolution et de nouveaux acteurs pourraient émerger à l’avenir.

Le marché du matériel d’IA connaît une croissance rapide. Alors que de plus en plus d’entreprises déploient des applications basées sur l’IA, la demande d’accélérateurs d’IA hautes performances augmente.

Maia 100 est bien placé pour répondre à cette demande. Grâce à ses fonctionnalités et capacités avancées, Maia 100 a le potentiel de devenir une plateforme d’accélération de l’IA de premier plan.

Crédit de l’image en vedette: Microsoft

Source: Microsoft présente la puce personnalisée Maia 100