Le Mistral Large 2 est arrivé, apportant un nouveau niveau de sophistication aux modèles de langage. Avec ses 123 milliards de paramètres massifs et une fenêtre de contexte impressionnante de 128 000 jetons, ce modèle peut traiter facilement de longs textes et des conversations complexes. Il est conçu pour être précis, réduisant les erreurs d’information tout en excellant dans le codage et les tâches multilingues.

Découvrez comment les capacités avancées de Mistral Large 2 repoussent les limites de ce que l’IA peut faire, de la résolution de problèmes mathématiques à la prise en charge d’un large éventail de langages de programmation.

Mistral Large 2 : Un aperçu complet

Mistral Large 2 se distingue comme une avancée significative dans le domaine des modèles linguistiques, combinant une échelle substantielle avec une technologie de pointe, et voici pourquoi.

Échelle du modèle et fenêtre contextuelle

Mistral Large 2 se distingue par ses 123 milliards de paramètres. Les paramètres sont les composants de base d’un modèle de langage, lui permettant d’apprendre et de générer du texte en fonction des modèles trouvés dans ses données d’entraînement. Le grand nombre de paramètres permet à Mistral Large 2 de comprendre et de générer du texte plus complexe et plus nuancé.

Le modèle dispose également d’une fenêtre contextuelle étendue de 128 000 jetons. Cette grande fenêtre contextuelle signifie que Mistral Large 2 peut traiter et générer du texte tout en maintenant la cohérence sur de très longs passages, ce qui le rend efficace pour gérer de longs documents et des conversations détaillées.

L’un des principaux défis des modèles linguistiques est la génération d’informations plausibles mais incorrectes, appelées hallucinations. Mistral Large 2 a été spécialement formé pour réduire ce problème. Il est conçu pour reconnaître lorsqu’il ne dispose pas d’informations suffisantes, plutôt que de générer un contenu potentiellement trompeur. Cette amélioration renforce la précision et la fiabilité du modèle.

Performances sur les benchmarks

Mistral Large 2 a démontré de solides performances dans divers benchmarks :

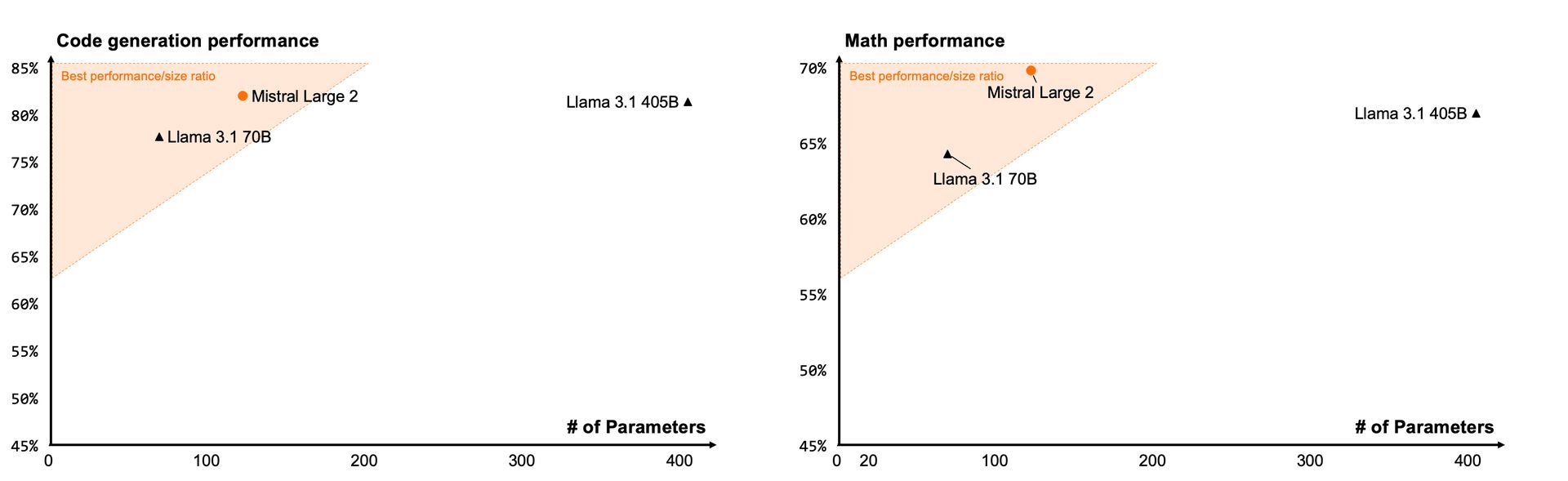

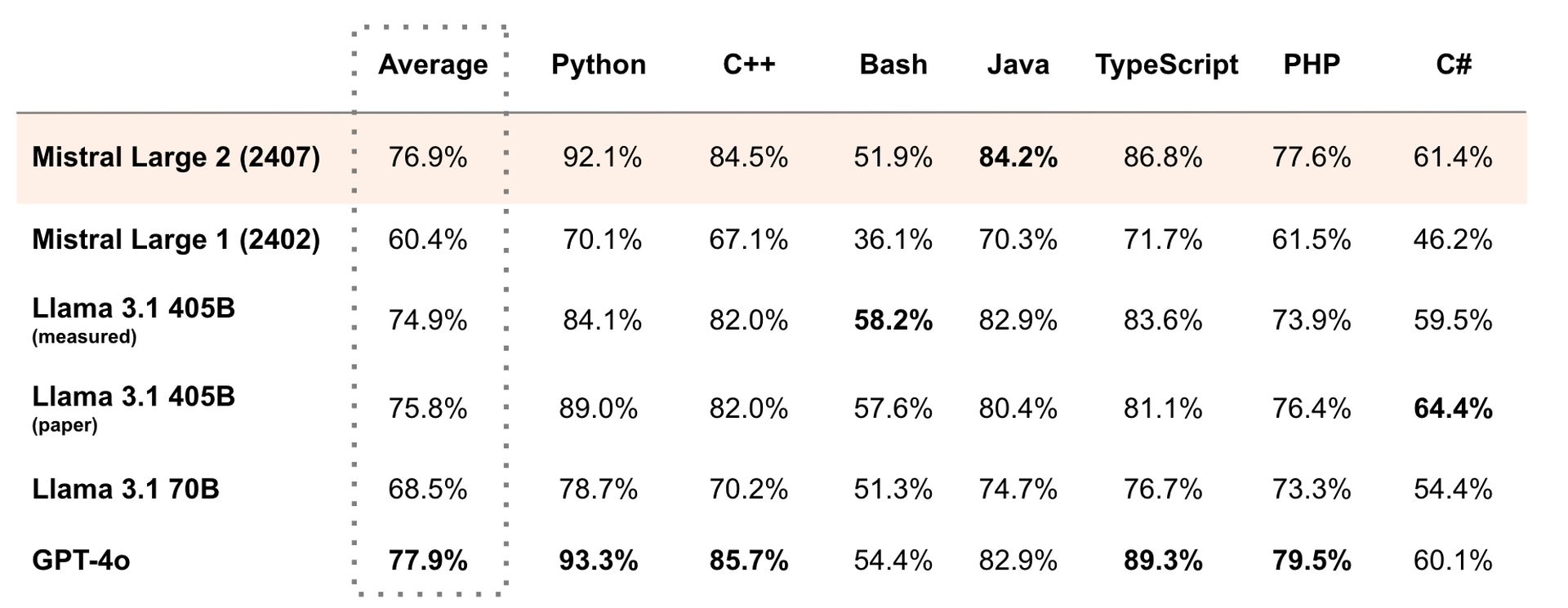

- Tâches de codage:Selon le benchmark HumanEval, qui teste les compétences en programmation, Mistral Large 2 affiche un niveau de compétence élevé, avec des performances comparables à celles des principaux modèles comme GPT-4. Cela indique sa capacité à comprendre et à générer du code de manière efficace.

- Résolution de problèmes mathématiques:Le modèle obtient de bons résultats au test MATH, qui évalue les capacités de résolution de problèmes mathématiques. Bien qu’il se classe juste derrière GPT-4, ses performances reflètent sa capacité à gérer des calculs complexes et des tâches logiques.

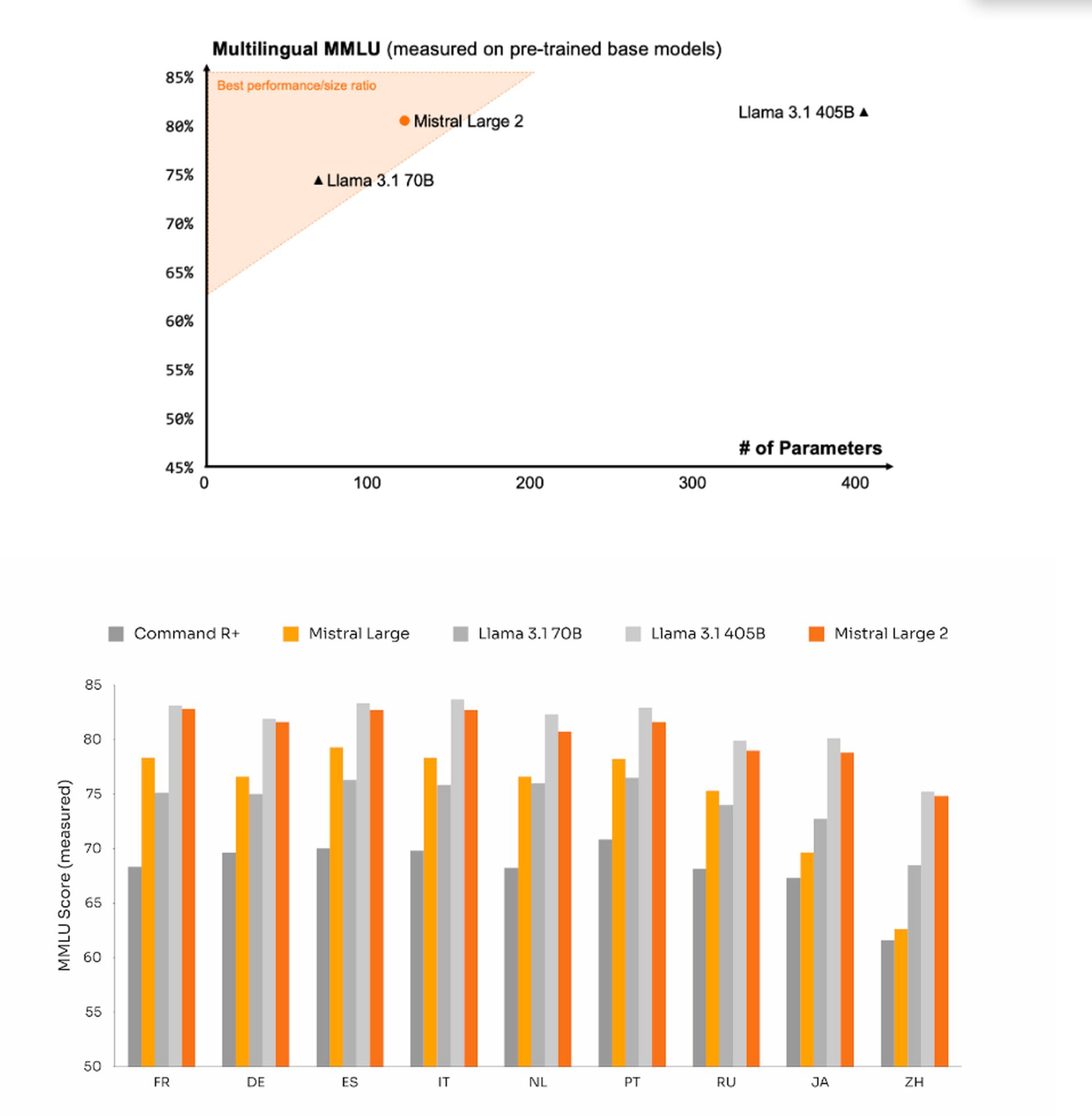

- Performance multilingue:Dans le test multilingue MMLU, Mistral Large 2 excelle dans plusieurs langues, démontrant sa capacité à traiter et à générer du texte dans divers contextes linguistiques.

Spécifications techniques

Mistral Large 2 est conçu pour fonctionner efficacement malgré sa grande taille. Il peut fonctionner sur une seule machine, ce qui est important compte tenu de sa taille. Cette efficacité est avantageuse pour les applications qui nécessitent de traiter rapidement de grandes quantités de texte.

Capacités de codage

Le modèle prend en charge plus de 80 langages de programmation, dont les plus populaires comme Python, Java, C, C++, JavaScript et Bash. Cette large prise en charge est le résultat d’une formation approfondie axée sur les tâches de programmation, faisant de Mistral Large 2 un outil polyvalent pour les développeurs et ceux qui travaillent avec du code.

Capacités multilingues

Mistral Large 2 est capable de traiter et de générer du texte dans de nombreuses langues, notamment :

- Langues européennes : français, allemand, espagnol, italien, portugais

- Langues asiatiques : arabe, hindi, russe, chinois, japonais, coréen

Cette prise en charge linguistique étendue permet au modèle de gérer diverses tâches et applications multilingues.

La partie manquante

Mistral Large 2 ne propose pas actuellement de fonctionnalités multimodales, qui impliquent de traiter simultanément du texte et des images. C’est un domaine dans lequel d’autres modèles, comme ceux d’OpenAI, ont actuellement un avantage. Les développements futurs pourraient combler cette lacune.

Comment utiliser Mistral Large 2

Mistral Large 2 est disponible sur plusieurs plateformes, notamment :

Pour l’expérimentation, Mistral propose également un accès via son concurrent ChatGPT, le Chat. Cependant, si le modèle est plus accessible que certains concurrents, il n’est pas open source et son utilisation commerciale nécessite une licence payante.

Alors, le nouveau modèle Large 2 de Mistral est-il suffisamment grand ?

Le modèle Large 2 de Mistral est en effet assez volumineux, avec 123 milliards de paramètres, ce qui en fait l’un des modèles de langage les plus complets disponibles. Cette échelle lui permet de gérer des tâches complexes de génération de texte et de maintenir la cohérence sur de longs passages. Sa fenêtre de contexte de 128 000 jetons améliore encore sa capacité à traiter et à générer des documents détaillés et longs.

En plus de sa taille, Mistral Large 2 a été optimisé pour minimiser les problèmes tels que la génération d’informations incorrectes, améliorant ainsi sa fiabilité. Il fonctionne également bien dans divers tests, notamment le codage et la résolution de problèmes mathématiques, et prend en charge plusieurs langages. Donc, oui, Mistral Large 2 est impressionnant de taille et de capacité, répondant aux besoins de nombreuses applications d’IA avancées.

Source: Le nouveau modèle Large 2 de Mistral est-il suffisamment grand ?