Un nouveau modèle d’IA open source Meta ImageBind qui relie de nombreux flux de données, tels que du texte, de l’audio, des données visuelles, des relevés de température et des relevés de mouvement, a été rendue publique par Meta.

Le modèle n’est actuellement qu’un effort de recherche sans consommateur immédiat ni applications pratiques, mais il suggère un avenir de Systèmes d’IA qui peuvent produire des expériences immersives et multisensorielles. Cela montre également à quel point ouvertement Méta partage toujours ses recherches sur l’IA contrairement à des concurrents comme OpenAI et Googlequi sont tous deux devenus plus reclus.

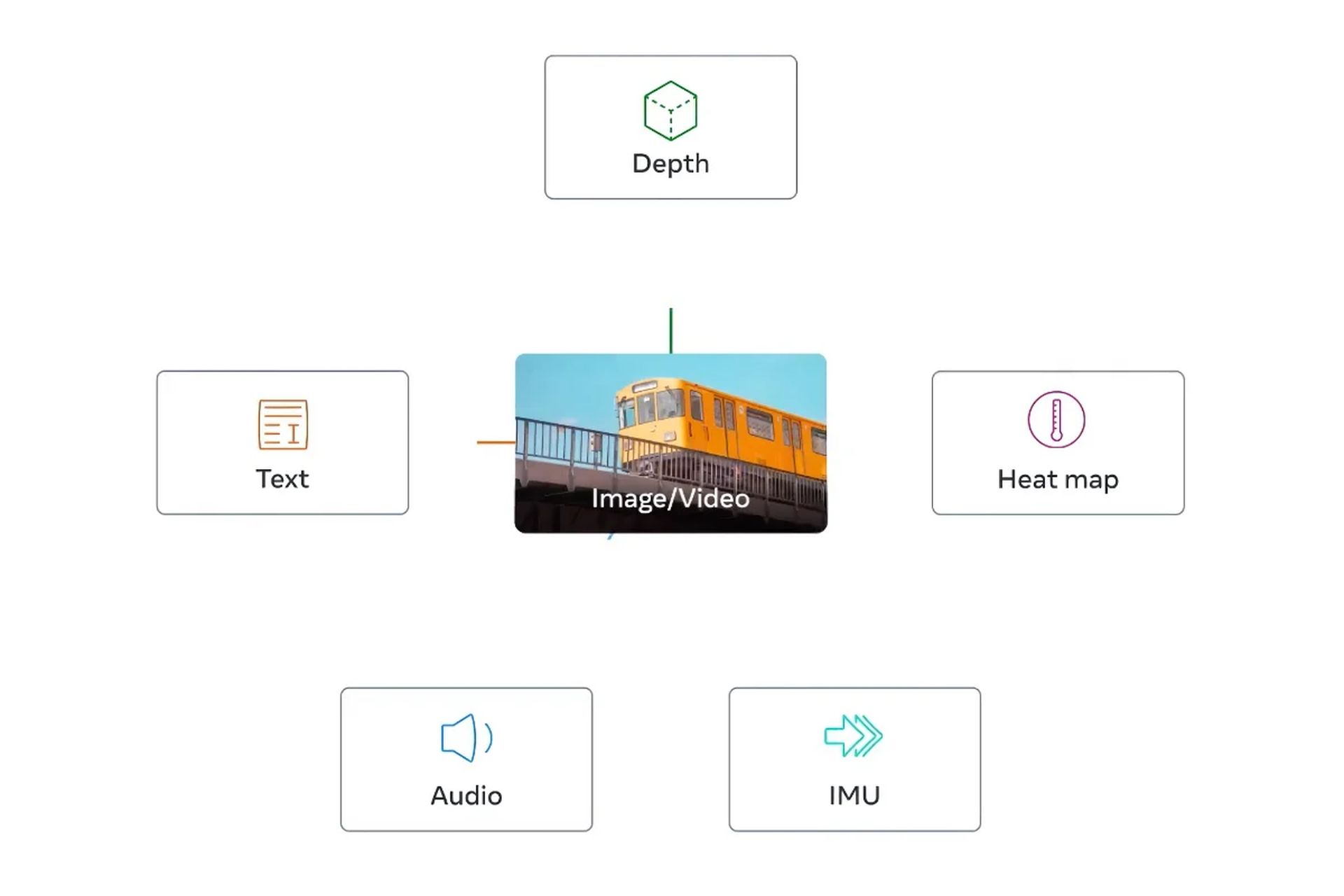

L’idée centrale de l’étude est l’intégration de plusieurs types de données dans un seul indice multidimensionnel (ou “incorporation espace,” utiliser Jargon de l’IA). Bien que cela puisse sembler un peu abstrait à ce stade, la notion fondamentale derrière la récente montée en puissance de l’IA générative est la même.

Qu’est-ce que Meta ImageBind AI ?

Par exemple, pendant la phase de formation, un certain nombre de générateurs d’images AI, y compris DAL–E, Écurie La diffusionet À mi-parcours, compter sur ces systèmes. Tout en reliant ces données aux descriptions des photos, ils recherchent des modèles dans les données visuelles. Cela permet donc à ces systèmes de produire des images qui correspondent aux saisies textuelles des utilisateurs. De nombreuses technologies d’intelligence artificielle produisent également de la vidéo ou de l’audio de la même manière.

Selon Meta ImageBind AI est le premier modèle à intégrer six différents formes de données dans un seul espace d’intégration. Les mesures visuelles (sous forme d’image et de vidéo), thermiques (images infrarouges), textuelles, audio, de profondeur et – le plus intrigant – de mouvement produites par une unité de mesure inertielle, ou IMU, sont les six catégories de données qui sont incorporées dans le modèle.

Les IMU sont utilisées dans les téléphones et les montres intelligentes pour diverses fonctions, notamment le passage d’un téléphone du mode paysage au mode portrait et l’identification de diverses formes de physique activité.

L’idée est que, comme les systèmes d’IA actuels le font avec des entrées de texte, les futurs systèmes d’IA pourront croiser ces données. Considérez un système de réalité virtuelle futuriste, par exemple, qui crée non seulement une entrée audio et visuelle, mais aussi votre environnement et mouvement sur une vraie scène.

Si vous lui demandiez de simuler une croisière en mer prolongée, cela vous mettrait sur un navire avec le tremblement du pont sous vos pieds et le vent froid de l’air océanique en plus du bruit des vagues au loin.

Comment fonctionne Meta ImageBind AI ?

Dans un article de blog, Meta ImageBind AI mentionne que les futurs modèles pourraient inclure des « signaux d’IRMf du toucher, de la parole, de l’odorat et du cerveau ». La découverte, selon la déclaration, “rapproche les machines de la capacité des humains à apprendre simultanément, de manière holistique et directement à partir de nombreuses formes d’informations différentes”. Ce qui est bien; peu importe. la minuterie de ces étapes déterminera.)

Naturellement, tout ceci est assez hypothétique, et il est probable que les usages immédiats de ce type d’étude seront considérablement plus contraints. Par exemple, Meta montré l’année dernière, un modèle d’IA qui crée des films brefs et flous à partir de descriptions textuelles. Les futures itérations du système pourraient combiner des flux de données supplémentaires, produisant de l’audio pour compléter la sortie vidéo, par exemple, comme le démontrent des travaux comme ImageBind.

Cependant, pour ceux qui suivent l’industrie, la recherche est particulièrement intrigante puisque Meta ImageBind AI ouvre le modèle sous-jacent, une tendance qui est étroitement surveillée dans le domaine de l’IA.

Approche open source de Meta ImageBind AI : Pourquoi ça marche ?

Ceux qui sont contre l’open source, comme OpenAIaffirment que l’approche est mauvaise pour les créateurs car les concurrents peuvent dupliquer leur travail et qu’elle peut même être dangereuse car elle pourrait permettre à des acteurs néfastes d’exploiter des modèles d’IA de pointe.

En réponse, les partisans affirment que l’open-sourcing permet à des tiers d’examiner les systèmes à la recherche de défauts et de corriger certaines de leurs lacunes. Ils soulignent que cela peut même avoir un avantage financier car cela permet effectivement aux entreprises d’embaucher des codeurs externes en tant qu’employés non rémunérés pour améliorer leur travail.

Bien qu’il y ait eu des défis, Meta ImageBind AI est resté solidement dans le camp open-source jusqu’à présent. (Par exemple, son modèle de langage le plus récent, Lamaa été mis en ligne au début de cette année.) À bien des égards, le manque de succès commercial de l’IA (elle n’a pas de chatbot pour rivaliser avec Bing, Bardeou ChatGPT) a rendu cette stratégie possible. Cette tactique est toujours utilisée avec ImageBind entre-temps.

Consultez les articles ci-dessous pour vous tenir au courant des dernières avancées technologiques, en particulier celles liées à l’IA.

- Est-ce que connaître ChatGPT est la clé pour être embauché : Oui, dit une startup japonaise

- Visual ChatGPT est là pour faire évoluer les générateurs de texte en image

- Midjourney V5 est là pour vous régaler les yeux !

Source: Le modèle Meta ImageBind AI innove dans l’IA générative