Gemma 2 vient de faire irruption sur la scène de l’IA 2D et fait beaucoup parler. Ce modèle miniature prouve que les bonnes choses viennent dans de petits paquets et suscite un véritable débat dans le monde de la technologie.

La dernière invention de Google, Gemma 2 2B, est un modèle de langage compact avec seulement 2,6 milliards de paramètres. Malgré sa petite taille, cette machine d’IA n’a rien à envier à ses grands frères. Non seulement elle parle, mais elle agit, égalant et même surpassant des modèles dix fois plus grands que lui.

La performance étincelante de Gemma 2 2B

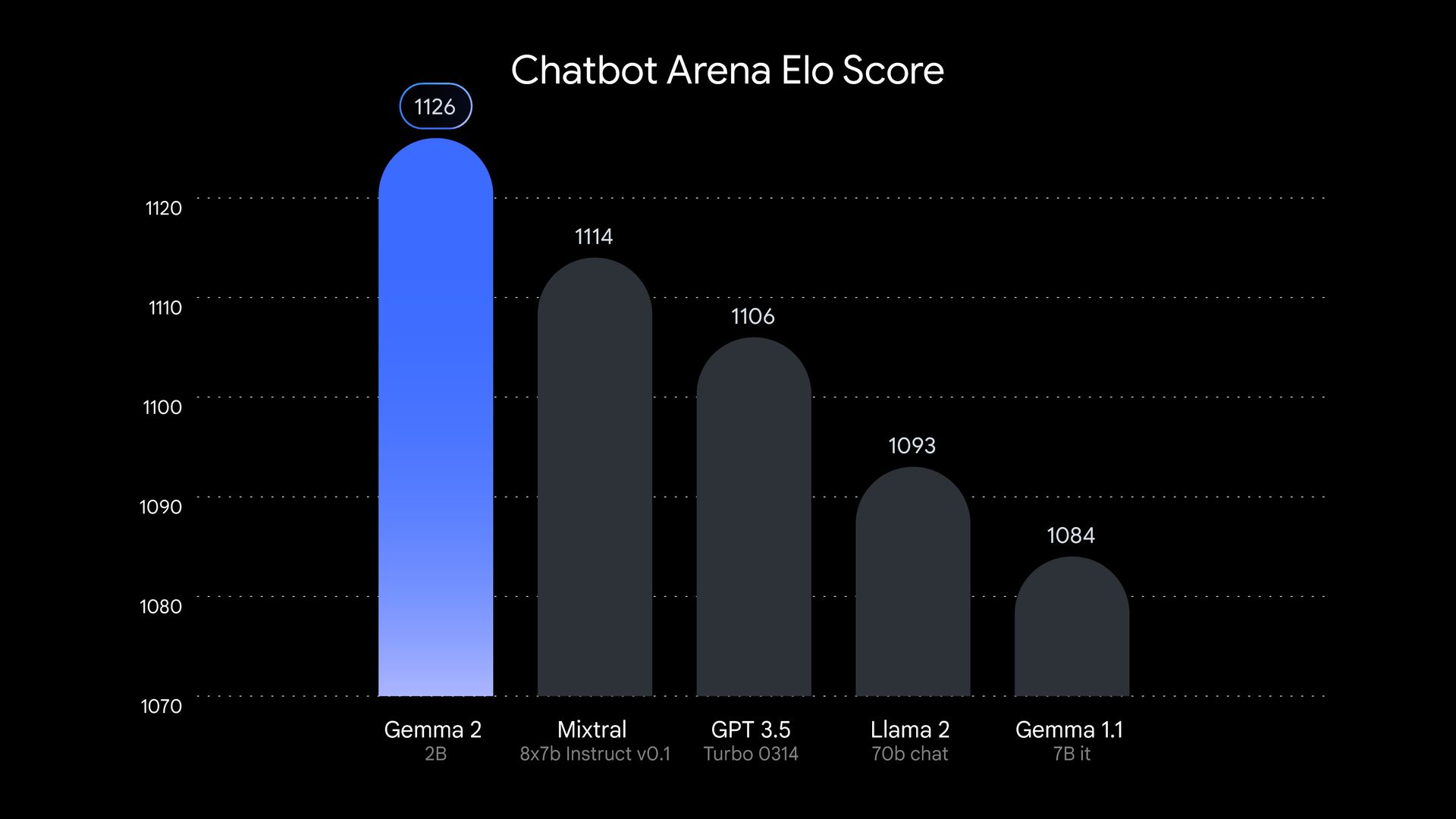

Soyons clairs sur le fait que Gemma 2 2B n’est pas une autre force majeure dans le grand groupe de l’IA. Ce modèle a été mis à l’épreuve et en est ressorti brillant. Lors des tests menés par LMSYSun groupe de recherche indépendant en IA, Gemma 2 2B a obtenu un score impressionnant 1130 points dans le domaine de l’évaluation. C’est vrai, ce petit bijou a surpassé certains grands noms comme GPT-3.5-Turbo-0613 et Mixtral-8x7B.

Mais la Gemma 2 2B ne s’arrête pas là. Elle montre qu’elle est intelligente dans d’autres domaines également. MMLU Dans le benchmark, qui teste la capacité d’un modèle à comprendre et à raisonner sur divers sujets, le Gemma 2 2B a obtenu 56,1 points. En ce qui concerne le codage, il a obtenu 36,6 points MBPP test. Ces chiffres représentent un bond en avant par rapport à son prédécesseur.

Alors, comment est-ce que Google a créé ce petit vous vous demandez peut-être ? Gemma 2 2B a été formé sur un ensemble de données massif de 2 000 milliards de jetons à l’aide du matériel avancé TPU v5e de Google. Ce processus de formation a permis au modèle de regrouper de nombreuses informations dans son cadre compact. Gemma 2 2B est également multilingue, ce qui élargit ses cas d’utilisation potentiels dans le monde entier. Cela en fait un outil polyvalent pour les développeurs et les chercheurs travaillant sur des projets internationaux.

Le succès de Gemma 2 2B remet en cause l’idée selon laquelle plus c’est gros, mieux c’est en IA. Ses performances impressionnantes montrent qu’avec les bonnes techniques d’entraînement, des architectures efficaces et des données de haute qualité, les petits modèles peuvent s’élever bien au-dessus de leur catégorie de poids. Cette évolution pourrait déplacer l’attention de la recherche en IA de la création de modèles plus grands vers l’amélioration de modèles plus petits et plus efficaces. Il s’agit d’un changement qui pourrait avoir des implications de grande portée pour le domaine et potentiellement rendre l’IA plus accessible et plus respectueuse de l’environnement.

Préparer l’avenir de l’IA

Gemma 2 2D représente une tendance croissante de l’IA vers des modèles plus efficaces. Alors que les préoccupations concernant l’impact environnemental et l’accessibilité des grands modèles linguistiques augmentent, les entreprises technologiques recherchent des moyens de créer des systèmes plus petits pouvant fonctionner sur du matériel de tous les jours.

Le succès de Gemma 2 2D souligne également l’importance des techniques de compression et de distillation des modèles. En condensant efficacement les connaissances issues de modèles plus volumineux dans des modèles plus petits, les chercheurs peuvent créer des outils d’IA plus accessibles sans sacrifier les performances.

Cette approche permet non seulement de réduire la puissance de calcul nécessaire à l’exécution de ces modèles, mais aussi de répondre aux préoccupations concernant l’impact environnemental de la formation et de l’exécution de systèmes d’IA de grande envergure. Il s’agit d’une situation gagnant-gagnant qui pourrait façonner l’avenir du développement de l’IA.

Gemma 2 2B prouve qu’en matière d’IA, ce n’est pas la taille qui compte, mais la façon dont on l’utilise. Ce modèle petit mais puissant remet en question nos hypothèses sur l’IA et ouvre la voie à une nouvelle génération de systèmes d’IA efficaces, puissants et accessibles. Il est clair que ce petit bijou brillera dans le monde de l’IA.

Crédits de l’image en vedette : Google

Source: La taille n’a pas d’importance : Gemma 2 2B prouve que l’IA peut penser petit