Un modèle d’apprentissage automatique texte-image appelé générateur d’art Stable Diffusion AI a été développé en collaboration avec EleutherAI, LAION et StabilityAI pour générer des images numériques à partir de descriptions en langage naturel.

La création d’art par l’IA n’est pas nouvelle. Cependant, des logiciels comme DALL-E 2, Midjourney AI et Stable Diffusion introduits cette année ont permis même aux artistes les moins qualifiés de créer des œuvres d’art complexes, abstraites ou réalistes en saisissant simplement quelques mots dans une zone de texte.

Le modèle de génération d’images open source de Stability AI est comparable à DALL-E 2 en termes de qualité. En outre, il a introduit DreamStudio, un site Web commercial qui fournit du temps de calcul pour la création d’images à diffusion stable. Stable Diffusion, contrairement à DALL-E 2, peut être utilisé par n’importe qui, et comme le code est open source, les projets peuvent s’en inspirer avec peu de restrictions.

Qu’est-ce que le générateur d’art Stable Diffusion AI?

Stability AI a lancé Stable Diffusion, un générateur d’art IA open source, le 22 août. Python est utilisé pour créer Stable Diffusion, et le concept de langage de transformateur est utilisé. Tout système d’exploitation prenant en charge les noyaux Cuda peut l’utiliser.

Grâce au paradigme de synthèse d’image open source Stable Diffusion, toute personne disposant d’un PC et d’un bon GPU peut créer presque toutes les réalités visuelles qu’elle peut imaginer. Il peut dupliquer pratiquement n’importe quel style visuel si vous lui donnez un texte descriptif, et les résultats apparaissent miraculeusement sur votre écran.

Contrairement aux méthodes comme DALL-E, Stable Diffusion met à disposition son code source. La licence interdit certaines situations d’utilisation à risque.

L’éthique de l’IA a été attaquée par des opposants, qui affirment que le modèle peut être utilisé pour créer des “deepfakes” et se demandent s’il est approprié de créer des images à l’aide d’un modèle formé sur un ensemble de données contenant du contenu protégé par le droit d’auteur sans le consentement des artistes.

L’ensemble de formation pour Stable Diffusion était un sous-ensemble de l’ensemble de données LAION-Aesthetics V2. Il a été formé sur 256 GPU Nvidia A100 en mode shopping pour 600 000 $.

Stability AI, la société qui sous-tend Stable Diffusion, est en pourparlers pour rechercher des capitaux à une valorisation pouvant atteindre 1 milliard de dollars en septembre 2022.

Exigences de téléchargement de diffusion stable

En 2022, un PC de jeu typique prendra en charge la diffusion stable, mais pas votre téléphone et la plupart des ordinateurs portables. Les prérequis pour le téléchargement de Stable Diffusion que vous devez remplir sont les suivants :

- Un GPU avec au moins 6 gigaoctets (Go) de VRAM

- Cela inclut la plupart des GPU NVIDIA modernes

- 10 Go (environ) d’espace de stockage sur votre disque dur ou votre disque SSD

- L’installateur Miniconda3

- Les fichiers Stable Diffusion de GitHub

- Les derniers points de contrôle (version 1.4, au moment de la rédaction, mais la 1.5 devrait bientôt sortir)

- L’installateur Git

- Windows 8, 10 ou 11

- Stable Diffusion peut également être exécuté sur Linux et macOS

Quelle est la taille du générateur d’art Stable Diffusion AI?

Vous avez besoin d’environ 10 Go d’espace de stockage sur votre disque dur ou votre disque SSD.

Vous pouvez utiliser IA à mi-parcours ou d’autres générateurs d’IA basés sur le Web si vous ne disposez pas du matériel nécessaire.

Comment exécuter le générateur d’art Stable Diffusion AI?

Voici les étapes à suivre pour exécuter le générateur d’art Stable Diffusion AI :

- Installer Gite

- Installer Miniconda3

- Télécharger le Référentiel GitHub de diffusion stable et le Dernier point de contrôle

Voyons de plus près comment vous pouvez les faire.

Installer Git

Les programmeurs peuvent gérer plusieurs versions du logiciel qu’ils développent à l’aide de la technologie appelée Git. Ils peuvent conserver différentes versions du logiciel sur lequel ils travaillent dans un référentiel partagé tout en permettant à d’autres développeurs de contribuer au projet.

Si vous n’êtes pas développeur, Git vous offre un moyen simple d’accéder à ces projets et de les télécharger. Nous l’appliquerons dans cette circonstance. Exécution de la Programme d’installation Windows x64 qui peut être obtenu sur le site Web de Git est nécessaire pour installer Git.

Vous aurez la possibilité de définir plusieurs options pendant l’exécution de l’installation ; laissez-les tous à leurs paramètres par défaut. Il est important de visiter la page d’options “Ajustement de votre environnement PATH”. Seul “Git à partir de la ligne de commande et également à partir d’un logiciel tiers” doit être sélectionné.

Installer Miniconda3

Stable Diffusion utilise une variété de bibliothèques Python. Si vous n’êtes pas familier avec Python, ne vous en faites pas trop ; il suffit de comprendre que les bibliothèques ne sont que des progiciels que votre ordinateur peut utiliser pour effectuer des tâches spécifiques, comme éditer une image ou effectuer des opérations arithmétiques difficiles.

Miniconda3 est essentiellement un outil pratique. Il vous permet de gérer toutes les bibliothèques nécessaires au fonctionnement de Stable Diffusion sans travail fastidieux. Cela affectera également la manière dont nous utilisons la diffusion stable dans des scénarios réels.

Visiter le Page de téléchargement Miniconda3 et choisissez “Miniconda3 Windows 64-bit” pour obtenir la version la plus récente.

Double-cliquez sur l’exécutable après l’avoir téléchargé pour démarrer l’installation. Par rapport à Git, l’installation de Miniconda3 implique moins de clics de page. Cependant, vous devez faire preuve de prudence avant de prendre cette décision :

Assurez-vous que “Tous les utilisateurs” est choisi avant d’appuyer sur le bouton suivant et de terminer l’installation.

Vous serez invité à redémarrer votre ordinateur après avoir installé Miniconda3 et Git.

Téléchargez le référentiel Stable Diffusion GitHub et le dernier point de contrôle

Après avoir installé le logiciel requis, nous pouvons télécharger et configurer Stable Diffusion.

Téléchargement du Dernier point de contrôle devrait venir en premier. Pour télécharger le point de contrôle, vous devez d’abord créer un compte, mais tout ce dont ils ont besoin est votre nom et votre adresse e-mail.

Le lien qui dit “sd-v1-4.ckpt” lancera le téléchargement. L’autre fichier, “sd-v1-4-full-ema.ckpt”, est presque deux fois plus volumineux, mais il pourrait produire de meilleurs résultats. Vous pouvez utiliser l’un ou l’autre.

L’étape suivante consiste à obtenir Diffusion stable de GitHub. Choisissez le bouton vert “Code”, puis cliquez sur “Télécharger ZIP”. Vous pouvez utiliser ce lien de téléchargement direct aussi bien.

Maintenant que nous avons décompressé les fichiers pour Stable Diffusion, nous devons créer quelques répertoires pour les décompresser. Cliquez sur le bouton Démarrer, tapez “miniconda3” dans la zone de recherche du menu Démarrer, puis choisissez “Ouvrir” ou “Entrée”.

Nous allons créer un dossier appelé “stable-diffusion” en utilisant la ligne de commande. Après avoir collé la section de code suivante dans la zone Miniconda3, appuyez sur Entrée.

Si tout se passe comme prévu, la fenêtre Miniconda3 apparaîtra. Gardez Miniconda3 ouvert car nous en aurons à nouveau besoin sous peu.

Utilisez votre archiveur de fichiers préféré pour ouvrir l’archive ZIP “stable-diffusion-main.zip” que vous avez téléchargée depuis GitHub. Windows peut ouvrir les fichiers ZIP de lui-même comme alternative si vous n’en avez pas. Tout en gardant le fichier ZIP ouvert dans la première fenêtre de l’Explorateur de fichiers, ouvrez une deuxième fenêtre et accédez au dossier “C:stable-diffusion” que nous venons de créer.

Faites glisser et déposez le dossier “stable-diffusion-main” dans le dossier “stable-diffusion” de l’archive ZIP.

Revenez à Miniconda3 et collez les commandes suivantes dans la fenêtre :

cd C:stable-diffusionstable-diffusion-main conda env create -f environment.yaml conda activate ldm mkdir modelsldmstable-diffusion-v1

Continuez la procédure. Étant donné que certains fichiers font plus d’un gigabit, le téléchargement peut prendre un certain temps. Si vous interrompez accidentellement le processus, vous devez supprimer le dossier d’environnement et redémarrer conda env create -f environment.yaml. Dans ce scénario, après avoir effacé le dossier “ldm” de “C:Users(Your User Account).condaenvs”, exécutez la commande précédente.

La dernière étape de l’installation est maintenant terminée. À l’aide de l’Explorateur de fichiers, copiez le fichier de point de contrôle (sd-v1-4.ckpt) et collez-le dans le dossier “C:stable-diffusionstable-diffusion-mainmodelsldmstable-diffusion-v1”.

Cliquez avec le bouton droit de la souris sur “sd-v1-4.ckpt” une fois le transfert du fichier terminé et sélectionnez “Renommer” dans le menu contextuel. Entrez “model.ckpt” dans le champ en surbrillance et appuyez sur Entrée pour renommer le fichier.

Nous en avons fini avec ça maintenant. La diffusion stable est désormais disponible. Mais comment ?

Guide Stable Diffusion : Comment utiliser le générateur d’art Stable Diffusion AI ?

Comment fonctionne la diffusion stable ? Suivez ces étapes pour utiliser au mieux le générateur d’art Stable Diffusion AI :

- Activer l’environnement ldm

- Changer de répertoire

- Utilisez txt2img.py et écrivez votre texte

- Attendez le processus

- Vérifiez les résultats

Chaque fois que vous souhaitez utiliser la diffusion stable, vous devez activer l’environnement ldm que nous avons conçu. Tapez conda activate ldm dans la fenêtre Miniconda3 et appuyez sur “Entrée”. Un environnement ldm actif est indiqué par le (ldm) sur le côté gauche.

Nous devons d’abord changer le répertoire (donc le commandcd) en “C:stable-diffusionstable-diffusion-main” avant de pouvoir créer des photos. Ajoutez le paramètre de ligne de commande cd C:stable-diffusionstable-diffusion-main.

Nous convertirons les invites de texte en 512512 visuels à l’aide d’un outil nommé txt2img.py.

Vous verrez une barre de progression sur votre console au fur et à mesure que les photos sont générées.

“C:stable-diffusionstable-diffusion-mainoutputstxt2img-samplessamples” est l’emplacement de toutes les images produites.

Exemples et invites de diffusion stable

Voici quelques-uns des meilleurs exemples de générateur d’art Stable Diffusion AI et de leurs invites :

Rapide: vagabond de la forêt par dominic mayer, anthony jones, Loish, style pictural par Gerald parel, craig mullins, marc simonetti, mike mignola, illustration de couleurs plates, lumineux et coloré, contraste élevé, mythologie, cinématographique, détaillé, atmosphérique, épique, art conceptuel, Matte painting, Seigneur des anneaux, Game of Thrones, puits d’éclairage, brume, photoréaliste, art conceptuel, lumière volumétrique, épopée cinématographique + règle des tiers | 35 mm| rendu d’octane, 8k, rendu corona, art conceptuel de film, rendu d’octane, 8k, rendu corona, cinématographique, tendance sur artstation, art conceptuel de film, composition cinématographique, ultra détaillé, réaliste, hyperréaliste, éclairage volumétrique, 8k -ar 3: 1 – test –uplight

Rapide: Environnement château nathria dans world of warcraft :: château de style gothique entièrement développé : cinématographique, pluvieux, nocturne, détaillé, épique, art conceptuel, peinture mate, puits d’éclairage, brume, photoréaliste, art conceptuel, lumière volumétrique, épopée cinématographique + règle des tiers, art conceptuel du film, 8k, cinématographique, tendance sur artstation, art conceptuel du film, composition cinématographique, ultra détaillé, réaliste, hyper réaliste, éclairage volumétrique, 8k -ar 3: 1

Rapide: portrait clair d’un concept de super-héros entre spiderman et batman, cottagecore !!, arrière-plan hyper détaillé, concept de personnage, corps entier, pose dynamique, complexe, très détaillé, peinture numérique, artstation, art conceptuel, lisse, mise au point nette, illustration, art par artgerm et greg rutkowski et alphonse mucha

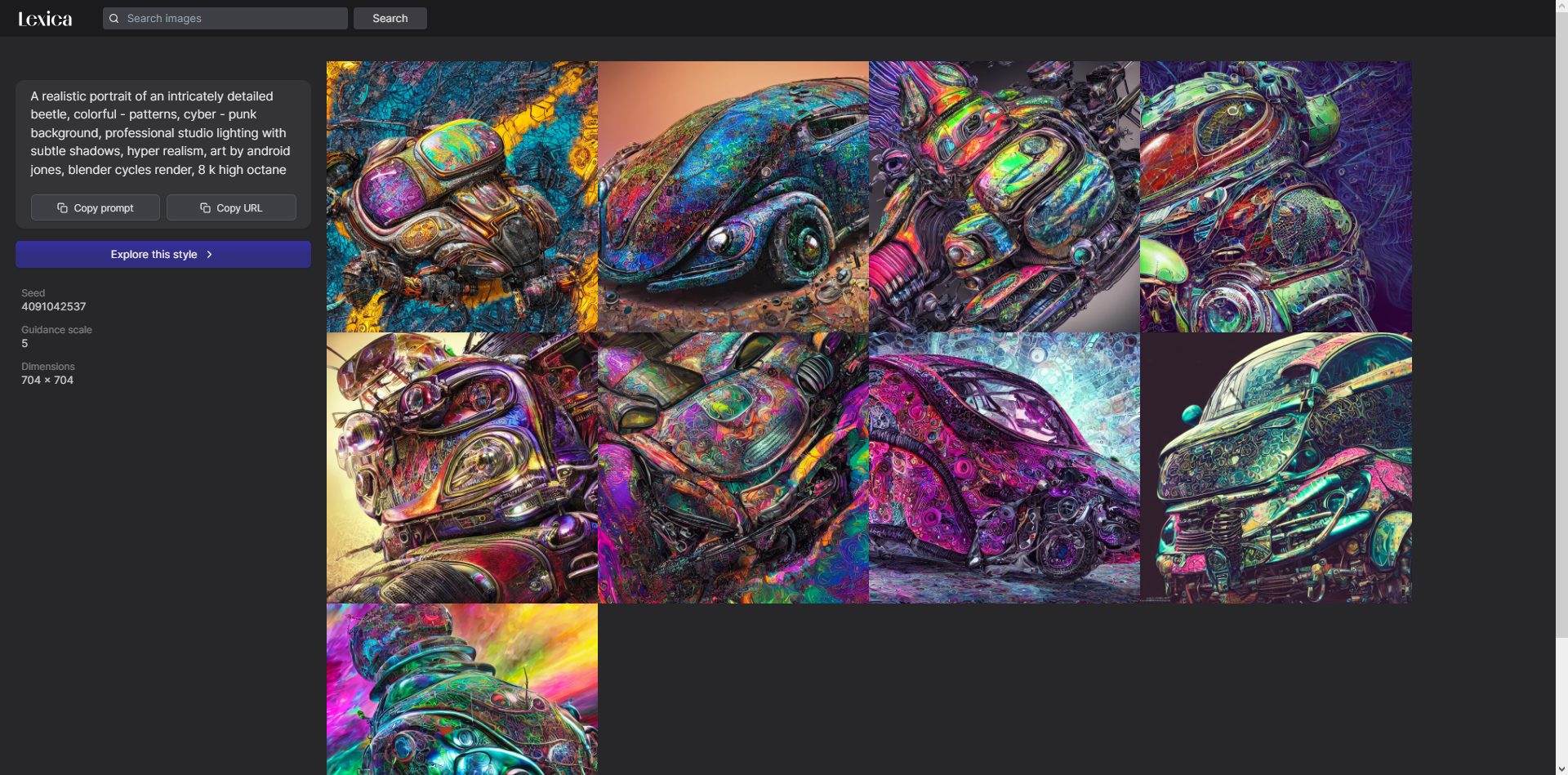

Qu’est-ce que Lexica Art ?

Lexica est une galerie et un moteur de recherche d’art créé avec Stable Diffusion.

Tu peux vérifier Lexique, un site Web pour un moteur de recherche qui utilise des images générées par l’IA à partir d’une diffusion stable. Lexica contient des invites pour les images générées automatiquement.

Stable Diffusion est-il open source ?

Oui. Les images utilisées dans Stable Diffusion, qui était open source le 22 août, ont été créées par un réseau neuronal formé sur des millions d’images récupérées sur Internet.

Un nouveau rival est récemment apparu pour DALL-E et Midjourney AI. Surtout, c’est gratuit ! Nous verrons comment les conflits du générateur d’art de l’IA impactent les choses.

Source: Générateur d’art Stable Diffusion AI : invites, exemples et mode d’exécution