Connaissez-vous l’histoire des technologies d’IA dont on parle constamment ? Aujourd’hui, nous allons plonger dans le sujet : “Depuis combien de temps l’IA existe-t-elle ?” ensemble avec toi.

L’intelligence artificielle (IA), un domaine relativement nouveau avec environ 60 ans d’histoire, est un ensemble de sciences, de théories et de méthodes qui tentent de reproduire les capacités cognitives humaines. Ceux-ci inclus:

- Logique mathématique

- Statistiques, probabilité

- Neurosciences computationnelles

- L’informatique

Commençant au milieu de la Seconde Guerre mondiale, ses progrès sont étroitement liés à ceux de l’informatique et ont permis aux ordinateurs d’assumer des tâches de plus en plus compliquées qui étaient auparavant exclusivement adaptées aux humains.

Depuis combien de temps l’IA existe-t-elle ?

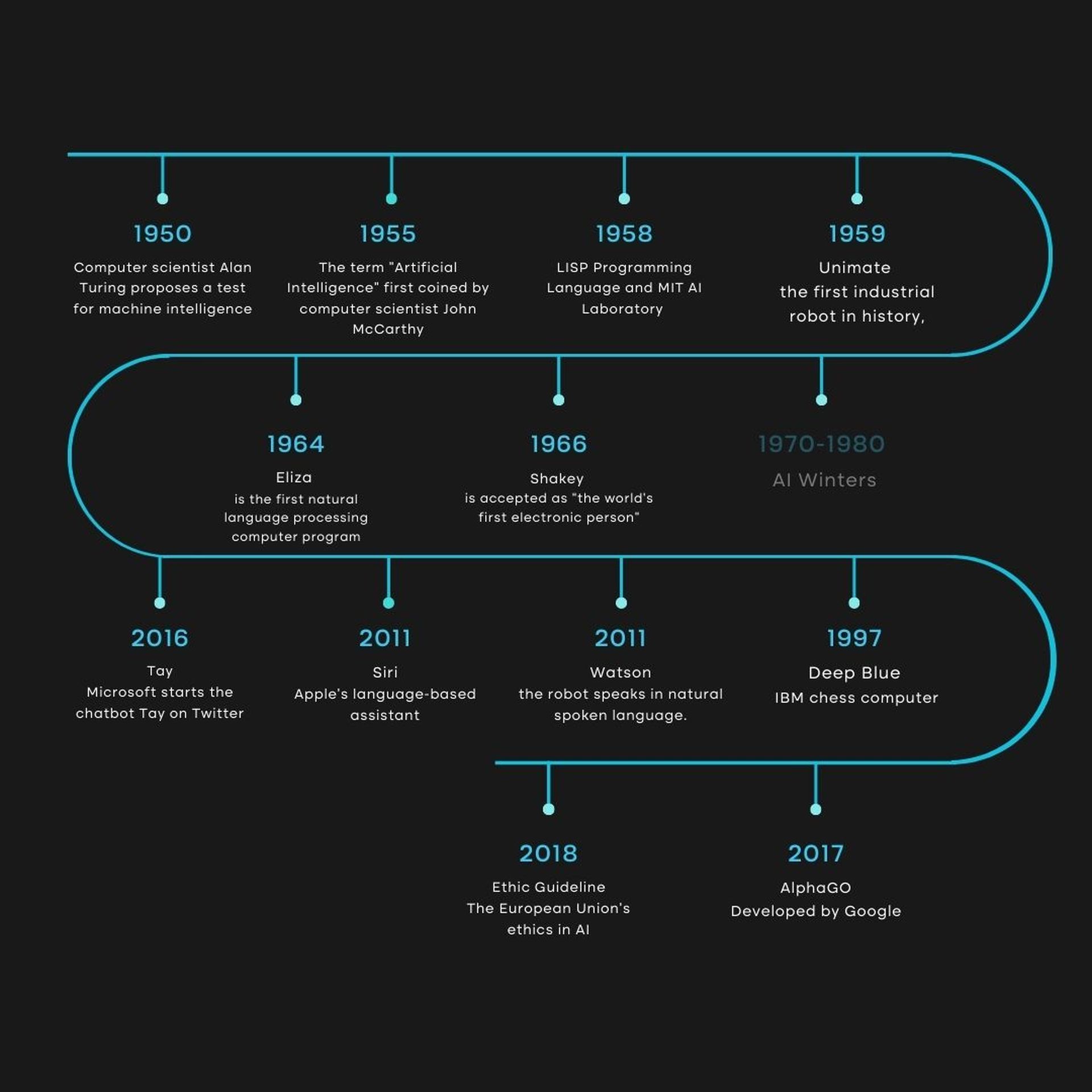

Depuis 1940, l’expression de l’intelligence artificielle (IA) fait partie de nos vies. Certains experts trouvent le terme trompeur car cette technologie est encore loin de la véritable intelligence humaine. Leur étude n’a pas encore atteint un point où elle puisse être comparée aux réalisations actuelles de l’humanité. Des avancées de la science fondamentale seraient nécessaires pour que l’IA “forte”, qui n’est encore apparue que dans la science-fiction, puisse modéliser le monde entier.

Cependant, depuis 2010, le domaine a connu un nouveau regain de popularité, principalement en raison des progrès significatifs de la puissance de traitement informatique et de l’accès facile à de grandes quantités de données. Une compréhension objective de la question est entravée par des promesses répétées et des inquiétudes parfois fantasmées.

À notre avis, un bref rappel de l’histoire de la discipline peut servir à encadrer les discussions actuelles.

1940-1960 : Naissance de l’IA

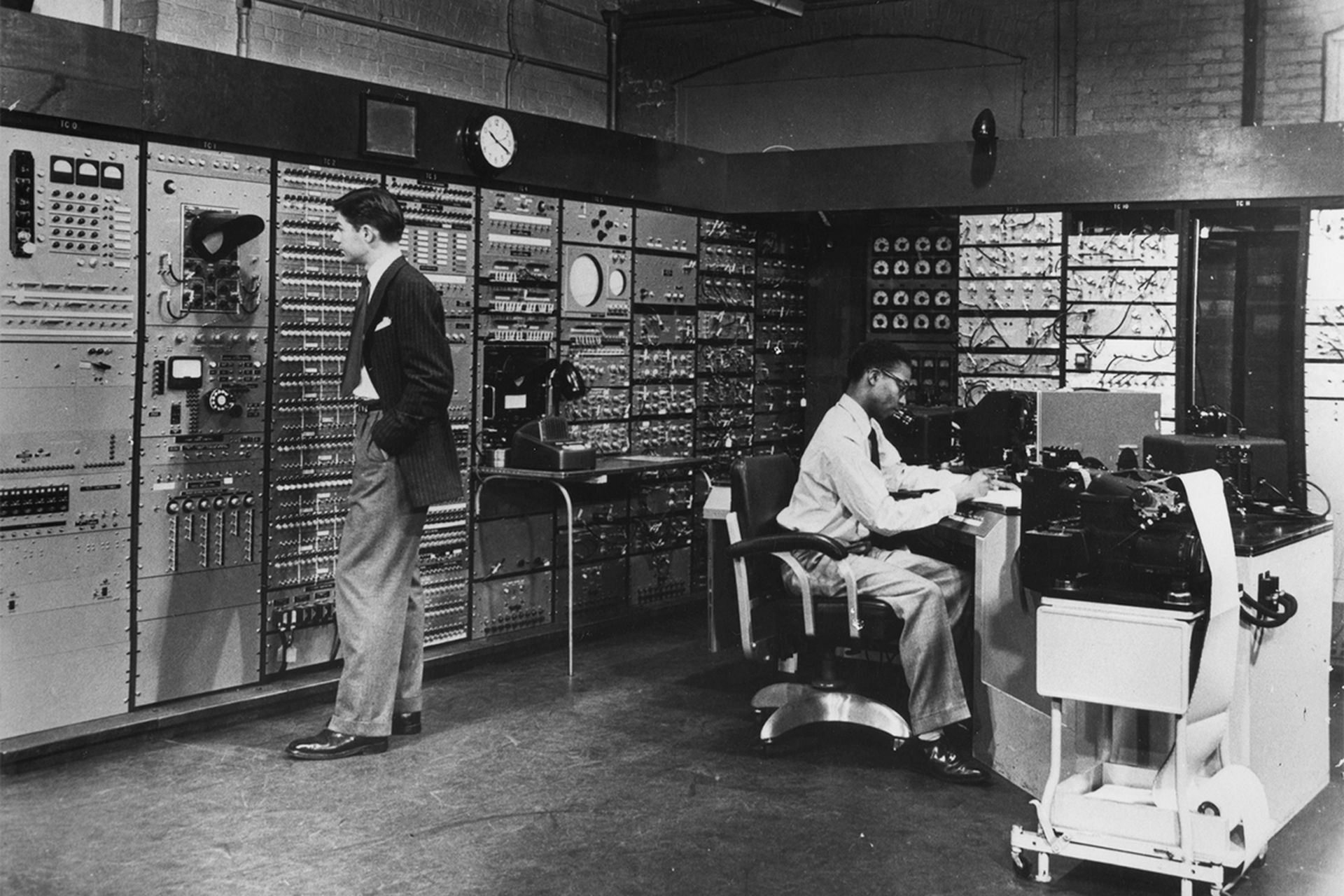

La confluence des progrès technologiques et la quête pour comprendre comment combiner le fonctionnement des machines et des êtres organiques entre 1940 et 1960 ont laissé une impression durable.

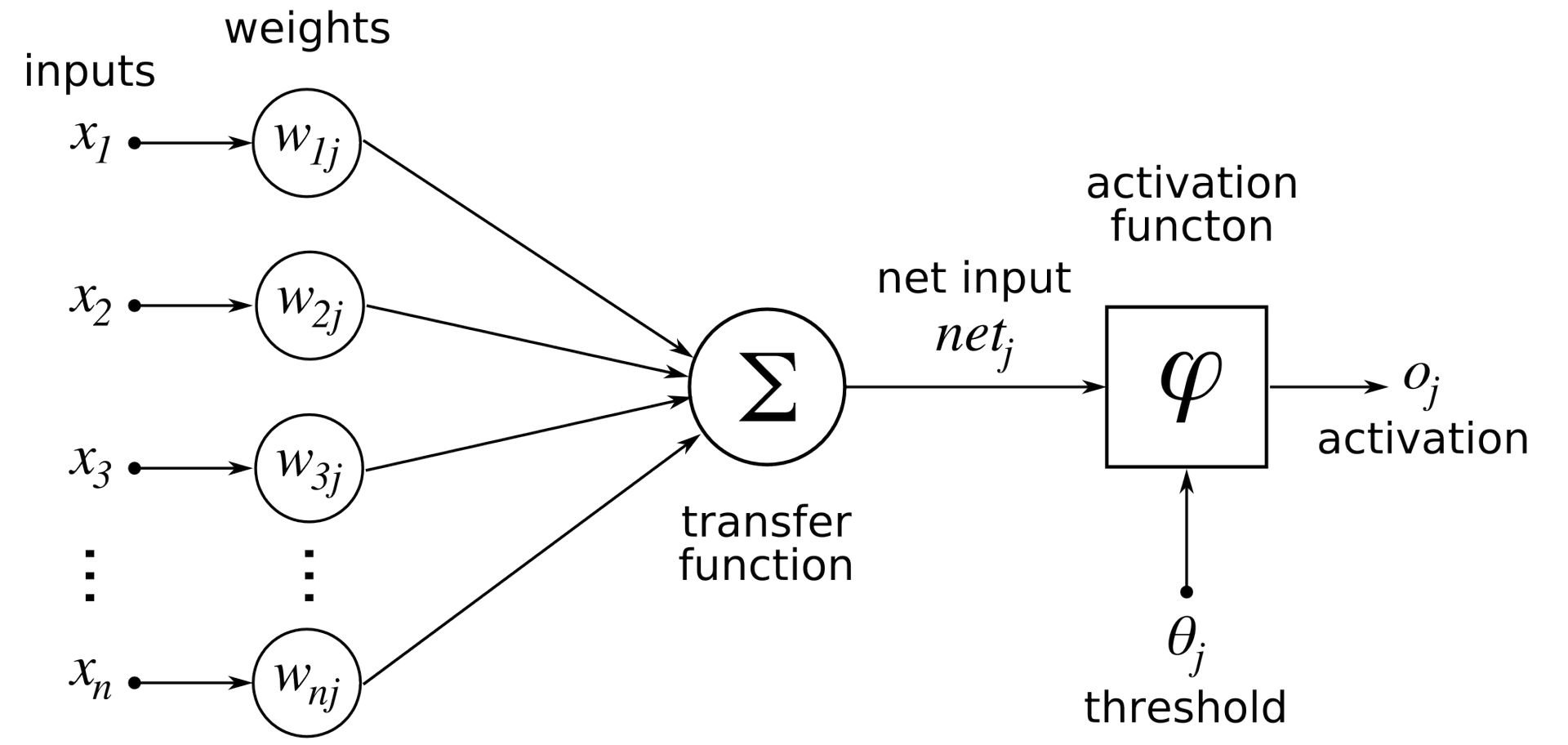

Pour créer « toute une théorie du contrôle et de la communication, à la fois chez les animaux et les machines », Norbert Wiener, pionnier dans le domaine de la cybernétique, a vu la nécessité d’intégrer la théorie mathématique, l’électronique et l’automatisation. Avant cela, Warren McCulloch et Walter Pitts ont créé le premier modèle mathématique et informatique du neurone biologique en 1943.

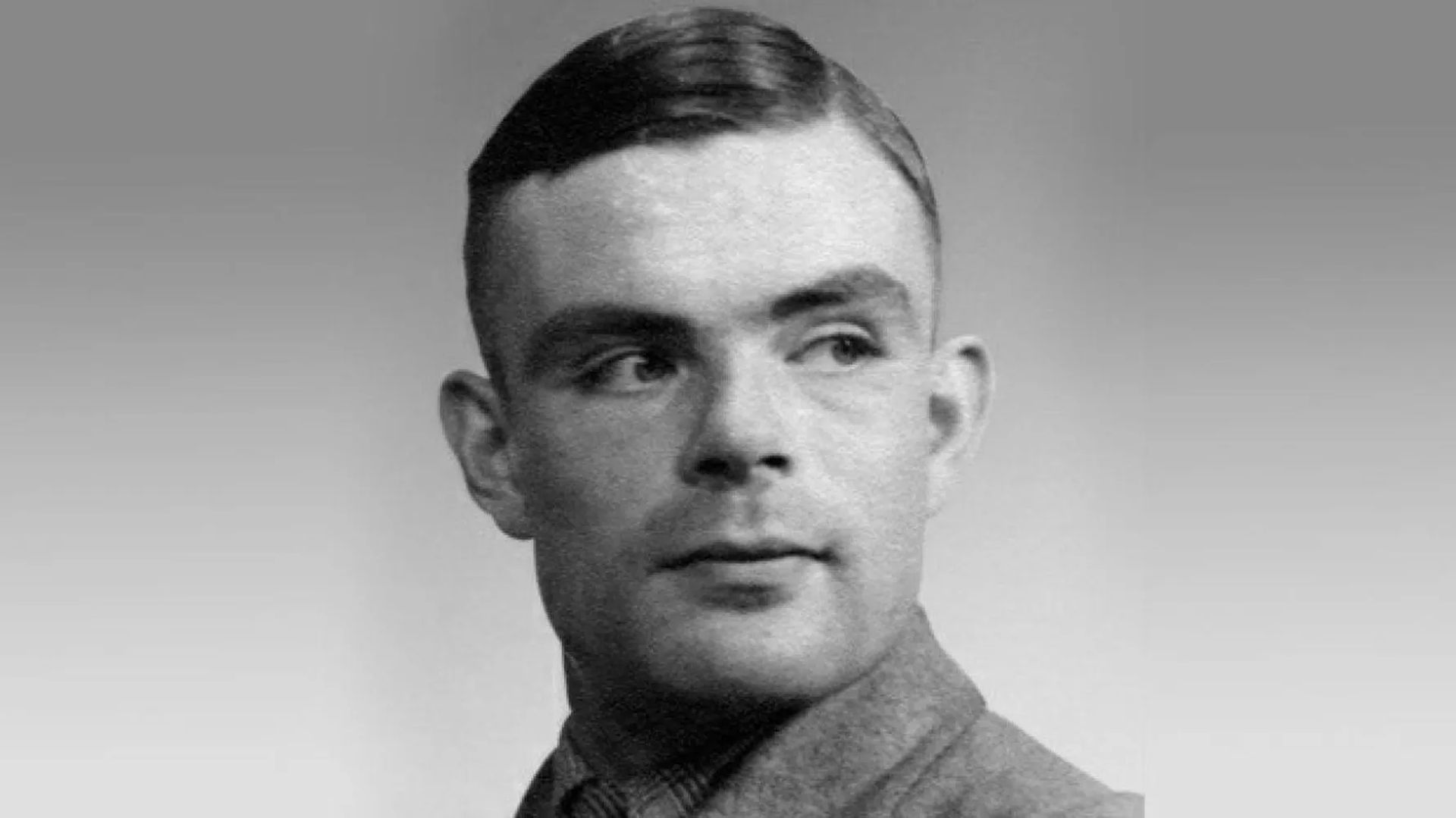

Bien qu’ils n’aient pas inventé le terme d’intelligence artificielle (IA) au début des années 1950, John Von Neumann et Alan Turing ont été les pionniers de la technologie qui la sous-tend. Ils ont aidé les ordinateurs à passer à la logique décimale du XIXe siècle et les machines à la logique binaire. Ainsi, les deux chercheurs ont codifié l’architecture des ordinateurs d’aujourd’hui et ont montré qu’il s’agissait d’un appareil universel capable d’exécuter ce qui était programmé. Turing, d’autre part, a défini un “jeu d’imitation” dans lequel une personne devrait être capable de dire dans une conversation par télétype si elle parle à un homme ou à une machine pour la première fois dans son célèbre article de 1950 “Computing Machinery and Intelligence.”

Aussi controversée soit-elle, cette pièce est souvent considérée comme le point de départ de discussions sur la ligne de démarcation entre les humains et les machines.

John McCarthy du MIT est crédité d’avoir inventé “l’IA”, que Marvin Minsky définit comme :

“Le développement de programmes informatiques qui s’engagent dans des tâches qui sont actuellement mieux réalisées par les humains car elles nécessitent des processus mentaux de haut niveau comme l’apprentissage perceptif, l’organisation de la mémoire et le raisonnement critique.”

On attribue à la discipline ses débuts lors d’un symposium tenu au Dartmouth College à l’été 1956. Pour l’anecdote, il est important de noter l’atelier qui a servi d’événement principal à la conférence. McCarthy et Minsky étaient deux des six personnes qui ont continuellement participé à cet effort.

Le début des années 1960 a vu un déclin de l’attrait de la technologie, même si elle continuait d’être passionnante et prometteuse. En raison de la faible quantité de mémoire des ordinateurs, l’utilisation d’un langage informatique était difficile.

L’IPL, ou langage de traitement de l’information, avait ainsi permis de développer le programme LTM, qui tentait de montrer des théorèmes mathématiques, dès 1956. Cependant, il y avait aussi quelques fondations qui sont encore présentes aujourd’hui, comme les arbres de solutions pour résoudre des théorèmes mathématiques.

1980-1990 : Systèmes experts

Le film de 1968 “2001 Space Odyssey”, réalisé par Stanley Kubrick, présente un ordinateur nommé HAL 9000 qui résume toutes les préoccupations éthiques soulevées par l’intelligence artificielle :

« Sera-t-il très sophistiqué, bénéfique pour l’humanité ou dangereux ?

L’influence du film ne sera évidemment pas scientifique, mais elle contribuera à faire connaître le thème, à l’image du romancier de science-fiction Philip K. Dick, qui n’aura de cesse de se demander si les machines peuvent un jour ressentir des émotions.

Les premiers microprocesseurs ont été introduits à la fin des années 1970, et les systèmes experts ont connu leur apogée alors que l’IA reprenait son envol. L’approche a été rendue publique à l’Université de Stanford en 1972 avec MYCIN et au MIT en 1965 avec DENDRAL. Ces systèmes reposaient sur un « moteur d’inférence », conçu pour être une réplique logique du raisonnement humain. En lui donnant des informations, le moteur a produit des réponses très bien informées.

Les promesses prévoyaient une avancée significative, mais à la fin de 1980 ou au début de 1990, l’enthousiasme aurait culminé. Il fallait beaucoup de travail pour mettre en place de telles informations, et entre 200 et 300 règles, il y avait un effet « boîte noire » qui obscurcissait la logique de la machine. Ainsi, la création et l’entretien sont devenus incroyablement difficiles, et surtout, il y avait de nombreuses autres options plus rapides, moins difficiles et plus abordables disponibles. Rappelons que dans les années 1990, l’expression « intelligence artificielle » avait pratiquement disparu du vocabulaire académique et que des formes plus discrètes, comme « l’informatique avancée », avaient même fait leur apparition.

En mai 1997, le supercalculateur Deep Blue d’IBM a remporté une victoire contre Garry Kasparov dans un match d’échecs, mais cela n’a pas encouragé le financement et l’avancement de ce type d’IA.

Deep Blue a opéré via une approche méthodique de la force brute dans laquelle tous les mouvements potentiels ont été pesés et évalués. Bien que Deep Blue n’ait été capable d’attaquer qu’une zone relativement restreinte et soit loin de pouvoir simuler la complexité du globe, la défaite de l’humain est restée un événement hautement symbolique dans l’histoire.

2010-Aujourd’hui : l’ère moderne de l’IA

Les technologies d’intelligence artificielle, qui ont attiré l’attention après la défaite de Kasparov face au supercalculateur Deep Blue, ont culminé à la mi-2010. Deux facteurs peuvent expliquer le nouvel essor de la discipline vers 2010 :

- Accès à d’énormes quantités de données

- Découverte des processeurs de cartes graphiques informatiques qui fonctionnent à un rendement extrêmement élevé

Les réalisations publiques rendues possibles par cette nouvelle technologie ont augmenté les investissements, et Watson, l’IA d’IBM, vaincra deux champions de Jeopardy en 2011.

Une IA sera capable d’identifier les chats dans les vidéos en 2012 grâce à Google X. Ce dernier défi a nécessité l’emploi de plus de 16 000 processeurs, mais le potentiel d’une machine capable d’apprendre à distinguer différentes choses était stupéfiant.

En 2016, Lee Sedol et Fan Hui, les champions d’Europe et du monde des Go Games, perdraient face à l’AI AlphaGO de Google.

D’où vient ce miracle ? Une rupture radicale avec les systèmes experts. La méthodologie a changé pour être inductive; au lieu de coder des règles comme dans le cas des systèmes experts, il est désormais nécessaire de permettre aux ordinateurs de les découvrir indépendamment par corrélation et catégorisation sur la base de grandes quantités de données.

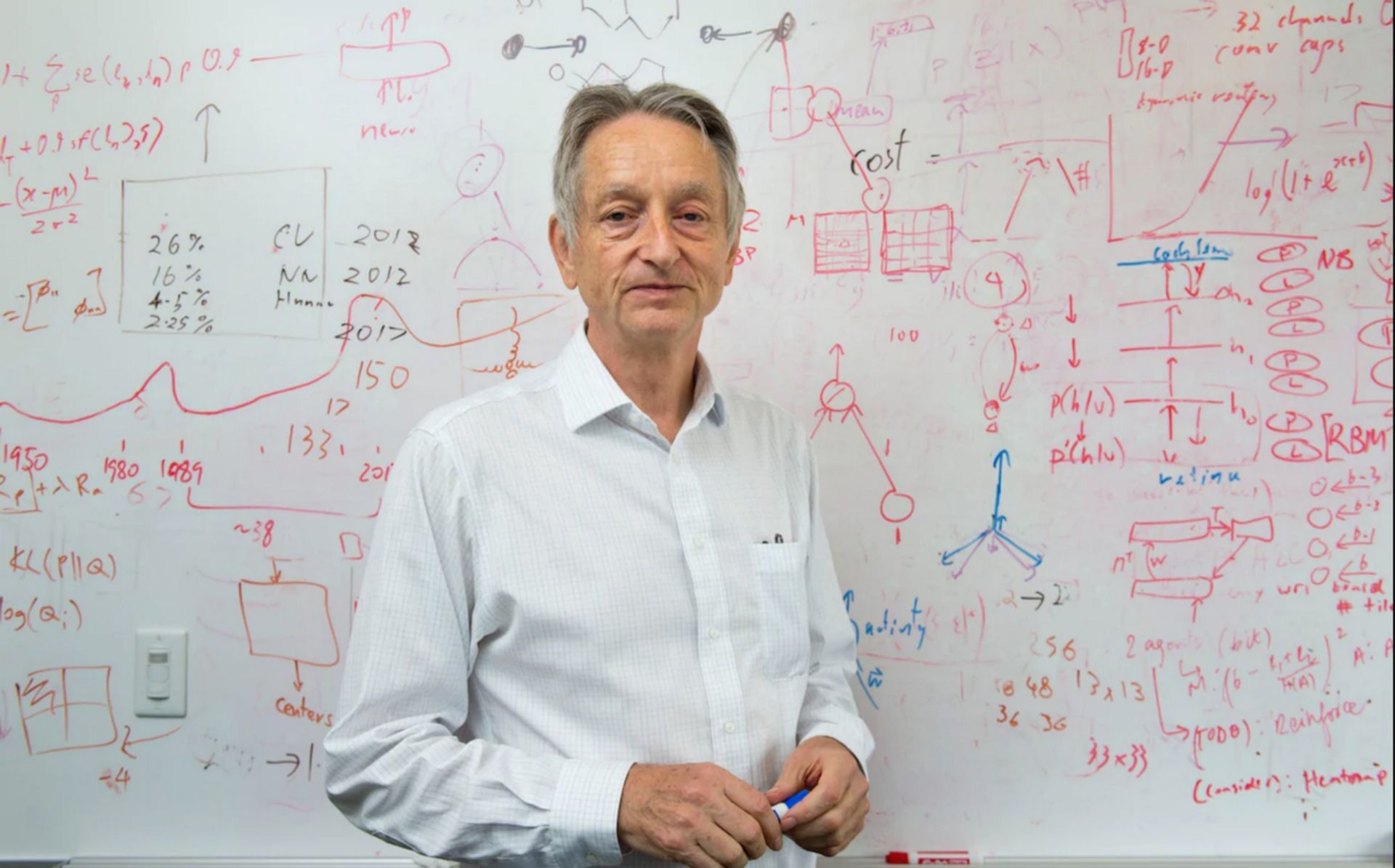

L’apprentissage en profondeur semble être la technologie d’apprentissage automatique la plus prometteuse pour une variété d’applications. Geoffrey Hinton, Yoshua Bengio et Yann LeCun ont décidé de lancer un programme de recherche en 2003 pour moderniser les réseaux de neurones. Avec l’aide du laboratoire de Toronto, des expériences menées simultanément à Microsoft, Googleet IBM ont révélé que ce type d’apprentissage réussissait à réduire de moitié les taux d’erreur de reconnaissance vocale. L’équipe de reconnaissance d’images de Hinton a connu un succès similaire.

Presque du jour au lendemain, la grande majorité des équipes de recherche ont adopté cette technologie, qui présentait des avantages indéniables. Bien qu’il y ait eu une amélioration significative de la reconnaissance de texte grâce à cette forme d’apprentissage, il reste encore beaucoup de chemin à parcourir avant de pouvoir créer des systèmes de compréhension de texte, selon des spécialistes comme Yann LeCun.

Les agents conversationnels illustrent bien cette difficulté : si nos smartphones sont actuellement capables de retranscrire des consignes, ils sont incapables de les contextualiser correctement ou de discerner nos intentions.

C’est ainsi que nous avons résumé pour vous le développement des technologies d’IA à ce jour. Continuez à nous lire pour ne pas ignorer les dernières nouvelles sur les technologies d’IA comme Notion AI et Meta Galactica AI

Source: Depuis combien de temps l’IA existe-t-elle : l’histoire de l’intelligence artificielle expliquée