Apple a décidé d’aller plus loin dans sa lutte contre la pédopornographie. La société a créé un nouveau système de numérisation et de cryptage avec lequel elle suivra les photos de ses utilisateurs à la recherche de contenu suspect. La nouvelle fonction basée sur le machine learning ne viendra pas dans certains pays pour le moment, elle sera testée dans un premier temps aux Etats-Unis, mais elle a déjà éveillé les soupçons des experts en cybersécurité.

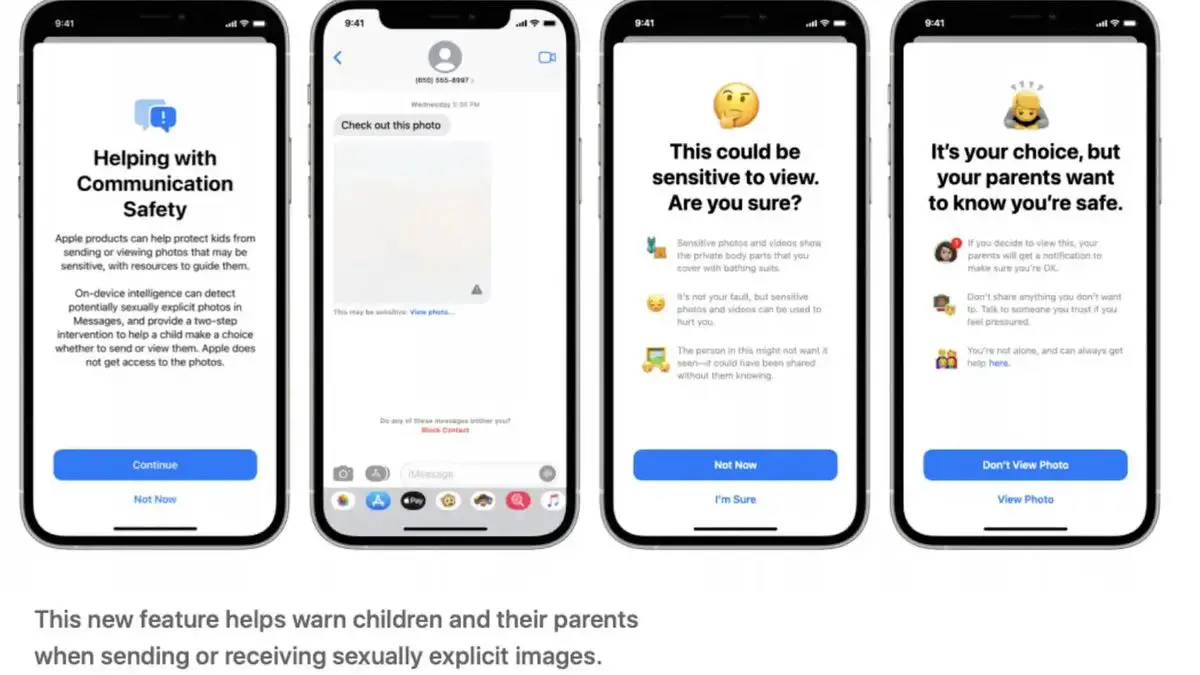

L’entreprise a ainsi confirmé jeudi l’information avancée sur Twitter par Matthew Green, professeur de cryptographie à l’université Johns Hopkins. Désormais, les utilisateurs d’iPhone recevront une alerte si l’une des images qu’ils tentent d’envoyer par iMessage est suspectée d’inculquer des abus sexuels sur des mineurs.

« Messages utilise l’apprentissage automatique sur l’appareil pour analyser les images jointes et déterminer si une photo est sexuellement explicite. La fonctionnalité est conçue pour qu’Apple n’ait pas accès aux Messages », détaille Apple dans un rapport décrivant le fonctionnement de ce système, ce qui n’est pas aussi nouveau qu’il y paraît.

Comment ça marche?

La technologie sera utilisée dans iOS, macOS, WatchOS et iMessages à partir desquels toutes les images que les utilisateurs ont l’intention de partager seront analysées. Pour ce faire, ils ont eu recours à des algorithmes d’apprentissage automatique appelés NeuralHash.

La technologie de hachage analyse l’image sans avoir besoin de la visualiser ou d’ouvrir le fichier. Il convertit chaque photographie en un numéro unique qui décrit son contenu, à la manière d’une empreinte digitale, mais qui serait impossible à comprendre pour tout utilisateur.

Après avoir comparé ce code avec ceux établis par l’entreprise comme contenu suspect, si suffisamment de correspondances sont détectées entre un code et un autre, une alerte est créée qui brouille l’image et l’empêche d’être partagée.

Apple garantit que les parents pourront recevoir des alertes si leurs enfants souhaitent envoyer du contenu classé comme suspect. Les autorités pourraient également être alertées de ces matchs afin qu’une équipe humaine puisse revoir les images.

Matthieu Vert explique sur son compte Twitter que cette technologie peut donner des faux positifs car peu précis : « C’est volontaire. Ils sont conçus pour trouver des images qui ressemblent à de mauvaises images, même si elles ont été redimensionnées, compressées, etc. La société nie cette affirmation : « Le risque que le système signale un compte de manière incorrecte est extrêmement faible. De plus, Apple examine manuellement tous les rapports transmis au NCMEC pour garantir l’exactitude des rapports. »

Les risques pour la vie privée

Ce qui pourrait être un outil clé pour poursuivre les criminels, les pédophiles et les terroristes, constitue à la fois une menace pour la vie privée de citoyens innocents et une arme très utile pour les régimes totalitaires, dénonce l’expert en cybersécurité.

Le problème avec ce nouvel outil serait plutôt de savoir où ils vont chercher ces similitudes. Les photos stockées sur les appareils et stockées dans iCloud sont stockées cryptées sur les serveurs Apple, mais comme l’expliquent les experts, les clés pour décrypter ces codes sont la propriété d’Apple.

Les seuls à avoir un cryptage de bout en bout (E2E) sont ceux d’iMessages qui, comme WhatsApp, sont protégés d’un appareil à l’autre afin que personne d’autre que les utilisateurs ne puisse les voir. C’est là, en théorie, qu’interviendrait le nouveau système d’Apple.

Cette analyse de contenu n’est pas si nouvelle. Facebook scanne les publications à la recherche de nudité sur ses réseaux sociaux (Facebook et Instagram). Apple a également utilisé des systèmes de hachage pour rechercher des images d’abus d’enfants envoyées par e-mail, des systèmes similaires à Gmail et d’autres fournisseurs de messagerie cloud, qui ne sont pas protégés par un cryptage de bout en bout.

Green pense que cette technologie envoie un message troublant. « Indépendamment des plans à long terme d’Apple, ils ont envoyé un signal très clair. (…) il est sûr de construire des systèmes qui scannent les téléphones des utilisateurs à la recherche de contenu interdit », explique-t-il sur son profil Twitter.

Cependant, tous les experts en cybersécurité n’ont pas été aussi critiques. Nicholas Weaver, chercheur principal à l’International Computer Science Institute de l’UC Berkeley, a assuré Carte mère que la nouvelle fonctionnalité Messages d’Apple “semble être une TRÈS bonne idée”. « Dans l’ensemble, l’approche d’Apple semble bien pensée pour être efficace et maximiser la confidentialité », ajoute-t-il.